O modelo O3 AI da OpenAI pontuou mais baixo na referência Frontiermath do que a empresa inicialmente implicava, de acordo com testes independentes de Epoch aio Instituto de Pesquisa por trás da Frontiermath. Quando o OpenAI divulgou a O3 em dezembro, afirmou que o modelo poderia responder a 25% das perguntas da FrontierMath, superando significativamente outros modelos.

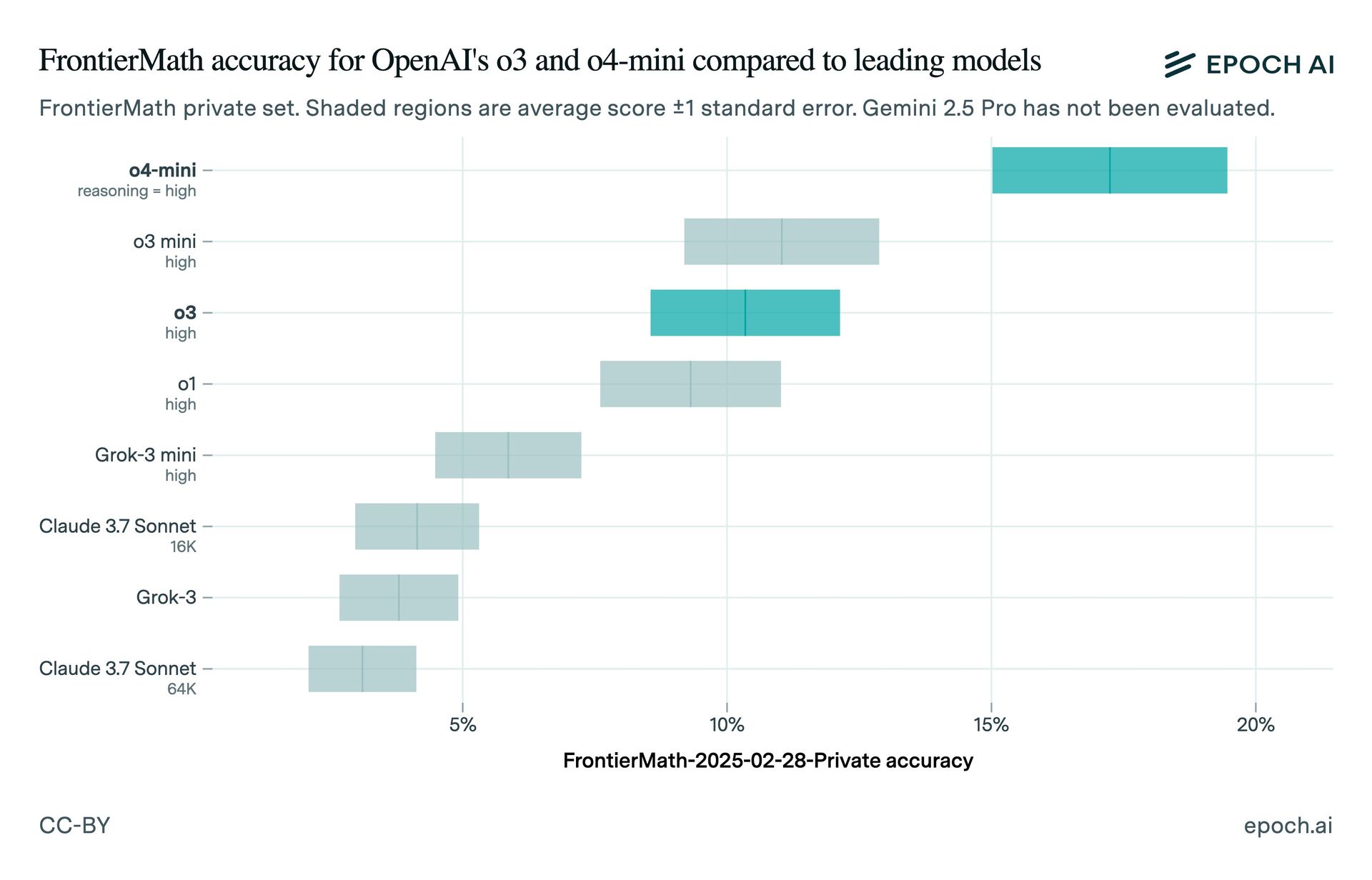

Os testes de Epoch AI descobriram que O3 marcou cerca de 10% na Frontiermath. A discrepância pode ser devida a diferenças nas configurações de teste ou à versão da O3 usada. O diretor de pesquisa do Openai, Mark Chen, teve declarou isso O3 alcançou mais de 25% em “Configurações agressivas de computação no tempo de teste”. A Epoch observou que os resultados de benchmark publicados da OpenAI mostraram uma pontuação com limite inferior que corresponde à época da pontuação de 10% observada.

O modelo público O3 está “ajustado para uso de bate-papo/produto” e possui níveis de computação menores do que a versão testada pelo OpenAI em dezembro, de acordo com a Fundação do Prêmio Arc, que testou uma versão pré-lançamento da O3. Wenda Zhou, do Openai explicado que o modelo O3 de produção é “mais otimizado para casos de uso do mundo real” e velocidade, o que pode resultar em disparidades de referência.

Os modelos O3-Mini-Mini-High e O4-Mini do Openai superam a O3 na Frontiermath. A empresa planeja lançar uma variante O3 mais poderosa, O3-Pro, nas próximas semanas. Este incidente destaca a necessidade de cautela ao interpretar os benchmarks de IA, principalmente quando são usados para promover produtos comerciais.

A indústria da IA viu várias controvérsias de benchmarking recentemente. Em janeiro, a Epoch foi criticada por não divulgar o financiamento do OpenAI até depois que a empresa anunciou a O3. A Xai foi acusada de publicar gráficos de referência enganosa para o seu modelo GROK 3 e a Meta admitiu divulgar as pontuações de referência para uma versão diferente de um modelo daquele disponível para os desenvolvedores.