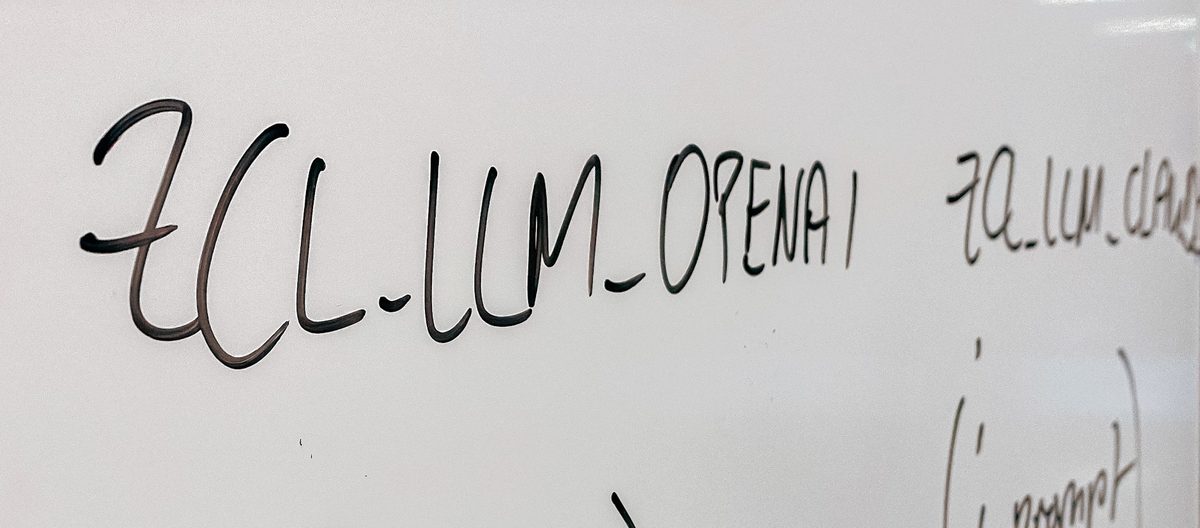

O Google DeepMind identificou uma limitação arquitetônica fundamental nos sistemas de geração de recuperação de recuperação (RAG) que dependem de incorporações densas. Essa limitação revela que as incorporações de tamanho fixo não podem representar todas as combinações de documentos relevantes como escala o banco de dados, impactando a eficácia da recuperação. A questão central está na capacidade representacional de incorporações de tamanho fixo. Uma incorporação de dimensão fixa não pode representar com precisão todas as combinações possíveis de documentos relevantes quando o banco de dados ultrapassa um determinado tamanho. Essa limitação está enraizada nos princípios da complexidade da comunicação e da teoria dos sinais. Limites de capacidade teórica com base na incorporação foram estabelecidos. As incorporações de 512 dimensões atingem seu limite em torno de 500.000 documentos. Aumentar as dimensões para 1024 estende o limite para aproximadamente 4 milhões de documentos. Um aumento adicional para 4096 dimensões eleva o teto para 250 milhões de documentos. Esses limites representam estimativas de melhor caso sob otimização de incorporação livre, onde os vetores são otimizados diretamente em relação aos rótulos de teste. De acordo com o relatório do Google DeepMind, prevê-se que as incorporações restritas ao idioma do mundo real falhem ainda mais. Para demonstrar empiricamente essa limitação, o Google Deepmind introduziu o benchmark limite, projetado para incorporadores de teste de estresse. O benchmark limite inclui duas configurações: limite completo e limite pequeno. A configuração completa do limite consiste em 50.000 documentos, onde mesmo os incorporadores fortes experimentam um colapso no desempenho, com recall@100 geralmente caindo abaixo de 20%. O limite é uma pequena configuração, compreendendo meros 46 documentos, ainda representa um desafio aos modelos. O desempenho varia significativamente, permanecendo longe de ser confiável. Resultados específicos do teste O limite Pequeno configuração inclui: Promptriever llama3 8b alcançado 54,3% recall@2 com 4096 dimensões. O gritlm 7b obteve 38,4% recall@2, também com 4096 dimensões. O E5-Mistral 7b atingiu 29,5% de recall@2, utilizando 4096 dimensões. A incorporação de Gêmeos alcançou 33,7% recall@2 com 3072 dimensões. A pesquisa mostra que, mesmo com apenas 46 documentos, nenhum incorporador alcança recall completo, enfatizando que a limitação decorre da própria arquitetura de incorporação de vetor único, não apenas do tamanho do conjunto de dados. Por outro lado, o BM25, um modelo lexical esparso clássico, contorna essa limitação. Os modelos esparsos operam em espaços dimensionais efetivamente ilimitados, facilitando a captura de combinações que as incorporações densas não podem representar efetivamente. As implementações atuais de RAG geralmente assumem que as incorporações podem escalar indefinidamente com o aumento dos volumes de dados. A pesquisa do Google DeepMind demonstra a incorreção dessa suposição, revelando que o tamanho da incorporação restringe a capacidade de recuperação inerentemente. Essa restrição afeta significativamente os mecanismos de pesquisa corporativa que gerenciam milhões de documentos, sistemas agênticos que dependem de consultas lógicas complexas e as tarefas de recuperação de seguidores de instruções, onde as consultas definem dinamicamente a relevância. Os benchmarks existentes, como o MTEB, não capturam adequadamente essas limitações porque testam apenas um subconjunto estreito de combinações de documentos de consulta. A equipe de pesquisa sugere que a recuperação escalável exige ir além das incorporações de vetor único. As alternativas às incorporações de vetor único incluem codificadores cruzados, que alcançam o recall perfeito no benchmark limite, marcando diretamente pares de documentos de consulta, embora com alta latência de inferência. Modelos multi-vetores, como Colbert, oferecem recuperação mais expressiva, atribuindo vários vetores por sequência, melhorando o desempenho nas tarefas de limite. Modelos esparsos, incluindo Retrievers BM25, TF-IDF e esparsos neurais, escalam melhor em pesquisa de alta dimensão, mas não têm generalização semântica. A descoberta principal é que a inovação arquitetônica, em vez de simplesmente aumentar o tamanho do incorporador, é essencial. A análise da equipe de pesquisa revela que incorporações densas, apesar de seu uso generalizado, são restringidas por um limite matemático. As incorporações densas não podem capturar todas as combinações de relevância possíveis, uma vez que os tamanhos do corpus excedem os limites ligados à incorporação da dimensionalidade. Essa limitação é demonstrada concretamente pelo benchmark limite, com recall@100 caindo abaixo de 20% no limite completo (50.000 documentos) e até os melhores modelos que se apagam em aproximadamente 54% de recall@2 no limite pequeno (46 documentos). Técnicas clássicas como o BM25, ou arquiteturas mais recentes, como retrievers e codificadores cruzados, permanecem essenciais para a construção de motores de recuperação confiáveis em escala.

DeepMind encontra limite de pano com incorporações de tamanho fixo

Related Posts

Recent Comments

Nenhum comentário para mostrar.