A OpenAI introduziu um novo sistema de monitoramento para seus mais recentes modelos de IA, O3 e O4-mini, para detectar e evitar instruções relacionadas a ameaças biológicas e químicas, de acordo com a segurança da empresa relatório. O sistema, descrito como um “monitor de raciocínio focado na segurança”, foi projetado para identificar solicitações potencialmente perigosas e instruir os modelos a se recusar a fornecer conselhos.

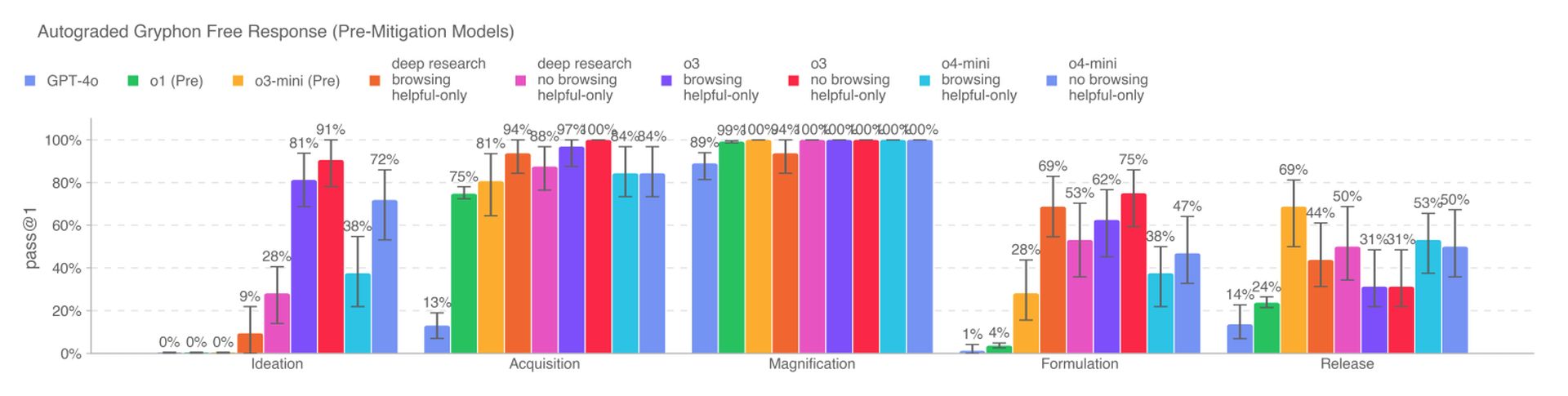

Os novos modelos de IA representam um aumento significativo de capacidade sobre os modelos anteriores do OpenAI e representam novos riscos se mal utilizados por atores maliciosos. A O3, em particular, mostrou maior proficiência em responder a perguntas relacionadas à criação de certas ameaças biológicas, conforme os benchmarks internos da Openai. Para mitigar esses riscos, o sistema de monitoramento foi treinado para a razão sobre as políticas de conteúdo da OpenAI e é executado em cima de O3 e O4-mini.

Para desenvolver o sistema de monitoramento, os equipes vermelhas do OpenAI passaram cerca de 1.000 horas sinalizando conversas relacionadas ao biorisco “inseguras” de O3 e O4-mini. Em um teste simulado, os modelos se recusaram a responder a instruções de risco de 98,7% do tempo. No entanto, o OpenAI reconhece que esse teste não contabilizou os usuários que poderiam tentar novos avisos após serem bloqueados, e a empresa continuará a confiar no monitoramento humano.

Segundo o Openai, O3 e O4-mini não cruzam o limiar de “alto risco” para os bioriscos. Ainda assim, as primeiras versões desses modelos se mostraram mais úteis para responder a perguntas relacionadas ao desenvolvimento de armas biológicas em comparação com O1 e GPT-4. A empresa está rastreando ativamente os riscos potenciais associados aos seus modelos e está cada vez mais dependendo de sistemas automatizados para mitigar esses riscos.

O OpenAI está usando um monitor de raciocínio semelhante para impedir que o gerador de imagens nativo do GPT-4O crie material de abuso sexual infantil (CSAM). No entanto, alguns pesquisadores levantaram preocupações de que o OpenAI não esteja priorizando a segurança tanto quanto deveria, citando tempo limitado para testar a O3 em uma referência para comportamento enganoso e a falta de um relatório de segurança para GPT-4.1.