Os pesquisadores de sementes de Bytedance lançaram o valor de política proximal aumentada de valor (VAPO), uma estrutura de treinamento de aprendizado de reforço projetada para aprimorar o raciocínio dos modelos de idiomas de grandes idiomas em tarefas complexas e longas, alcançando novos resultados de ponta na referência AIME24.

A Treination LLMS para raciocínio complexo, usando o aprendizado de reforço baseado em valor anteriormente enfrentou obstáculos significativos. Os métodos lutaram com o viés do modelo de valor, adaptando-se efetivamente às seqüências de resposta de comprimentos amplamente variados e gerenciando sinais de recompensa escassos, especialmente em tarefas baseadas em verificador, fornecendo apenas feedback binário.

O VAPO aborda esses desafios por meio de três inovações principais: uma estrutura de treinamento detalhada baseada em valor, uma estimativa de vantagem generalizada (GAE), baseada em valores (GAE), ajustando os parâmetros com base no comprimento da resposta e na integração sistemática de técnicas de pesquisas anteriores.

Essa combinação cria um sistema em que as melhorias funcionam sinergicamente. Usando o modelo QWEN2.5-32B sem dados específicos da SFT, o VAPO melhorou as pontuações de benchmark de 5 a 60, superando métodos anteriores de última geração em 10 pontos.

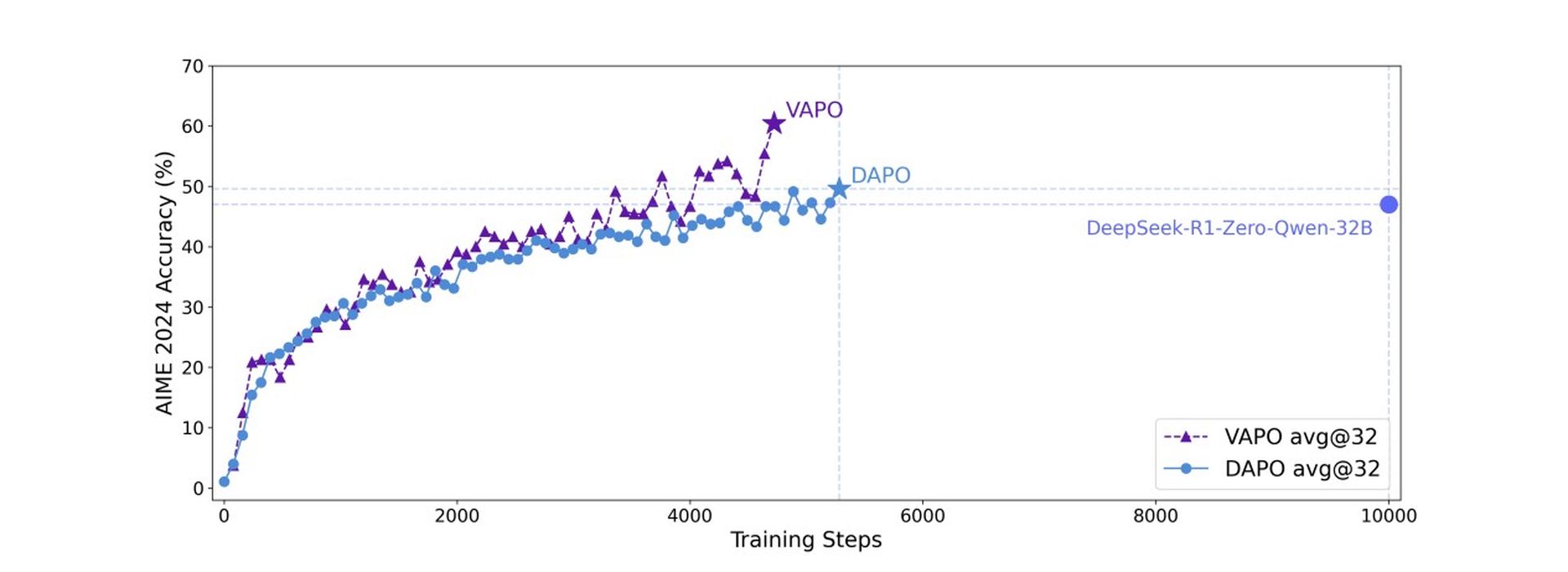

O VAPO se baseia no algoritmo de otimização da política proximal (PPO), mas incorpora modificações importantes para melhorar o raciocínio matemático. A análise de treinamento revelou que o VAPO exibe curvas de treinamento mais suaves em comparação com o método DAPO sem valor, indicando otimização mais estável.

O VAPO também demonstrou uma melhor escala de comprimento para melhorar a generalização, um crescimento mais rápido atribuível aos sinais granulares de seu modelo de valor e menor entropia em estágios de treinamento posteriores. Embora a entropia reduzida possa potencialmente limitar a exploração, o método equilibra efetivamente isso, melhorando a reprodutibilidade e a estabilidade com o mínimo impacto no desempenho.

Na referência AIME24, Deepseek R1 usando o GRPO alcançou 47 pontos e o DAPO alcançou 50 pontos. O VAPO, usando o modelo QWEN-32B, correspondeu ao desempenho da DAPO com apenas 60% das etapas de atualização e definiu uma nova pontuação de 60,4 de última geração em 5.000 etapas. Por outro lado, o Vanilla PPO marcou apenas 5 pontos devido ao colapso do aprendizado de modelo de valor.

Este benchmark pergunta se a IA pode pensar como um engenheiro

Os estudos de ablação confirmaram a eficácia de sete modificações distintas no VAPO. A pré-fixação do valor impede o colapso do modelo; O GAE dissociado permite a otimização total de respostas longas; O GAE adaptativo equilibra a otimização de resposta curta e longa; O Clip-Higher incentiva a exploração completa; A perda no nível do token aumenta a ponderação para respostas longas; A incorporação de perda de LM positiva adicionou 6 pontos; E a amostragem de grupo contribuiu com 5 pontos para a pontuação final.

Pesquisadores destaque Esse vapo, utilizando o modelo QWEN2.5-32B, demonstra que essa abordagem baseada em valor pode superar decisivamente métodos livres de valor como GRPO e DAPO, estabelecendo um novo nível de desempenho para tarefas complexas de raciocínio e abordando desafios fundamentais nos modelos de valor de valor para cenários de cadeia longa de pensamento.