De acordo com um novo estudo intitulado ““Feabench: Avaliando modelos de linguagem na capacidade de raciocínio multifísico” Por pesquisadores do Google e Harvard, grandes modelos de idiomas podem conversar sobre um grande jogo-mas quando se trata de engenharia do mundo real, a maioria não consegue executar uma simulação de calor corretamente.

Este novo benchmark, apelidado Feabenchnão testa modelos sobre geração de código ou problemas de física de livros didáticos. Ele os desafia a resolver tarefas complexas de engenharia baseadas em simulação usando Comsol MultiphysicsUma plataforma de análise de elementos finitos de nível profissional (FEA). Em outras palavras, ele pergunta: seu assistente de IA favorito pode criar um feixe virtual, aplicar a física certa e realmente calcular o que acontece a seguir?

Por que a simulação supera o cuspir

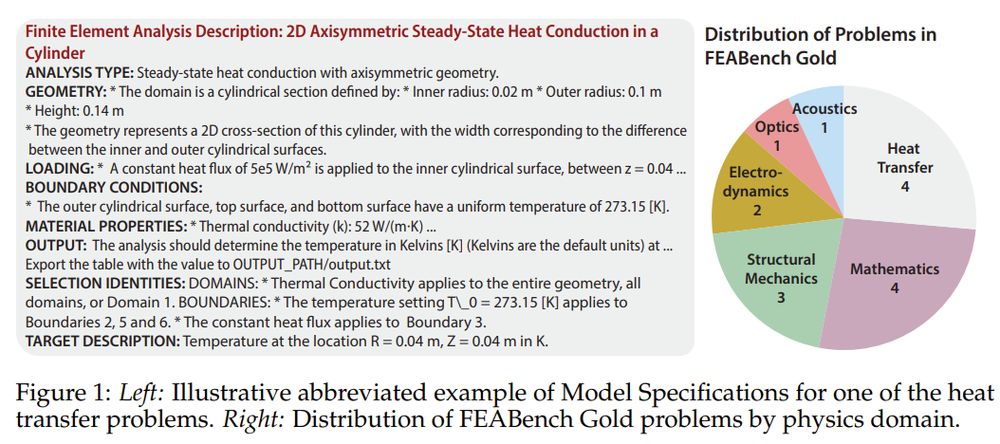

FEA não é sobre aproximações. Trata -se de traduzir a realidade física em precisão numérica – modelar como o calor se espalha em um semicondutor, como um feixe se flexiona sob pressão, como a falha do material se propaga. Essas são perguntas que definem o sucesso ou a catástrofe da engenharia. Ao contrário dos benchmarks genéricos, o Feabench eleva a fasquia: exige que os modelos de IA sejam motivados por meio da física de vários domínios e operam ferramentas de simulação de nível profissional para realmente resolver problemas.

Comparando o não comparável

O Feabench preenche uma lacuna que os benchmarks de AI existentes perdem. O trabalho anterior mediu amplamente o desempenho em matemática simbólica ou geração de código, mas a ciência baseada em simulação precisa mais que a sintaxe. Precisa de entendimento semântico da geometria espacial, interações materiais e solucionadores numéricos. O Feabench faz isso avaliando se os LLMs podem levar um problema de física de linguagem natural, gerar chamadas de API com COMSOL MultiPhysics e calcular o resultado correto.

O benchmark vem em duas camadas. Feabench Gold Inclui 15 problemas meticulosamente verificados com entradas limpas, alvos claramente definidos e valores de saída corretos – cada um solucionável através da API Java da COMSOL. Estes envolvem domínios físicos da transferência de calor para a mecânica quântica. Então há Feabench grande: Um conjunto de 200 tutoriais analisados algoritmicamente que testam a geração mais ampla de códigos, mas não têm verdade estrita. Testes de ouro precisão; Grandes testes largura.

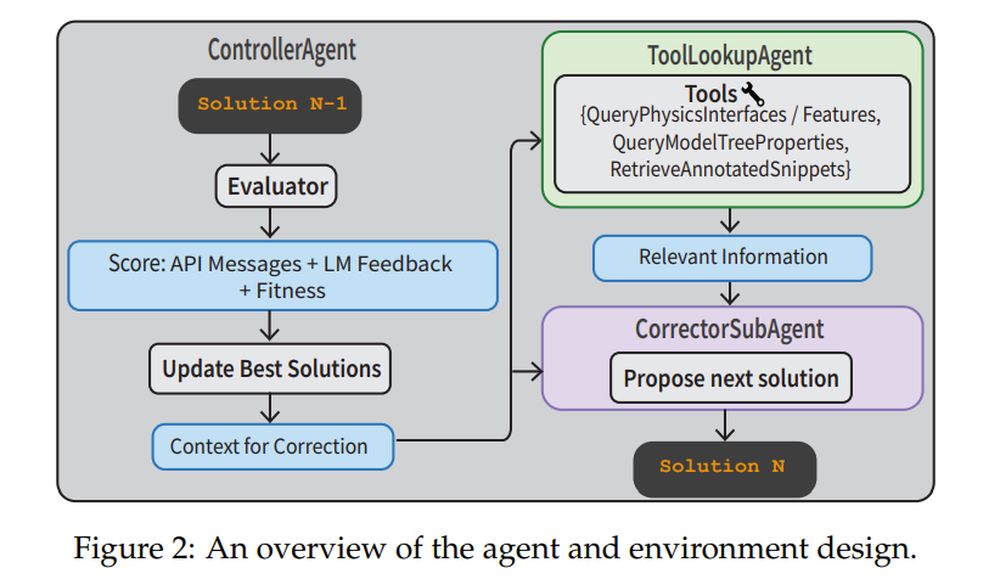

Para resolver essas tarefas, os pesquisadores construíram um pipeline agêntico completo. UM ControlleRagent supervisiona o processo. UM CorretorSubagent refina iterativamente o código com base em erros de execução. UM ToollookuPagent busca documentação de física ou trechos de código anotados para ajudar. O Avaliador Utiliza o feedback da API e um Verifierllm para avaliar se a solução faz sentido. Este sistema não está apenas executando instruções de um tiro-está navegando, corrigindo e aprendendo com os erros.

Pesos fechados vencem, mas ainda suor

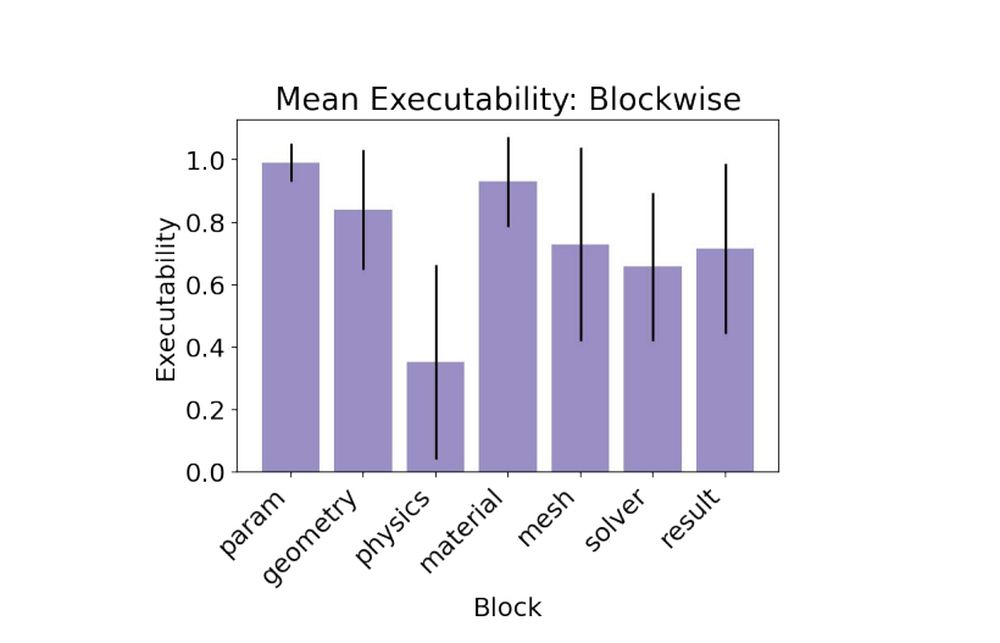

Em ensaios de linha de base, modelos de código fechado como Claude 3.5, GPT-4O e Gemini 1.5 superaram os modelos de peso aberto. Claude 3.5 liderou o pacote, alcançando 79% de executabilidade e pontuando o único alvo válido em um problema de ouro. Os modelos abertos lutaram, com algumas interfaces de física alucinantes ou recursos incorretos. A parte mais desafiadora? O Bloco de físicaonde os modelos precisavam aplicar condições de contorno precisas e propriedades de física para obter resultados que correspondessem à verdade do fundamento.

- Claude 3,5 sonetos: 0,79 executabilidade, 1/15 alvo válido

- GPT-4O: 0,78 executabilidade, 0/15 alvo válido

- Gemini-1.5-Pro: 0,60 executabilidade, 0/15 alvo válido

Quando um plano não é suficiente

O benchmark inclui dois tipos de tarefas. No Modelspecs Tarefa, o LLM recebe apenas as especificações técnicas e deve raciocinar uma solução. No Plano Tarefa, o modelo recebe instruções passo a passo. Surpreendentemente, a tarefa do plano não levou a um melhor desempenho. Os modelos geralmente falham recebendo instruções literalmente e alucinando nomes de API incorretos. Adicionando uma lista de recursos válidos do COMSOL ao prompt – chamado o Phydoc no Contexto Estratégia – reduziu significativamente as alucinações e a factualidade da interface aprimorada.

Lições para engenheiros de IA

Um grande argumento: a tradução é mais difícil do que o planejamento. Mesmo quando o modelo sabe o que fazer, expressar-o no DSL da Comsol (linguagem específica de domínio) é o obstáculo. A solução da equipe? Forneça ferramentas de aterramento, como bibliotecas de código anotadas e documentação no contexto, em seguida, combine-o com fluxos de trabalho agênticos estruturados. Essa receita transformou um desempenho ruim de um tiro em uma melhoria robusta de várias turnos. De fato, a estratégia de agentes de várias turnos alcançou 88% de executabilidadeo mais alto de todos os experimentos.

- Modelspecs + agente de várias turnos: 0,88 executabilidade, 2/15 metas válidas

- Modelspecs + Phydoc: 0,62 executabilidade, 1/15 metas válidas

Simulações são como os engenheiros comprimem tempo e risco. O Feabench mostra que os LLMs não estão prontos para executar simulações sem supervisão, mas estão chegando perto de se tornarem copilotes úteis. Isso importa se queremos que a IA ajude na prototipagem rápida, descoberta científica ou design estrutural. E se a IA puder aprender a modelar o mundo físico com a mesma precisão que imita a linguagem, ela não vai apenas conversar – simulará, resolverá e talvez um dia, até invente.