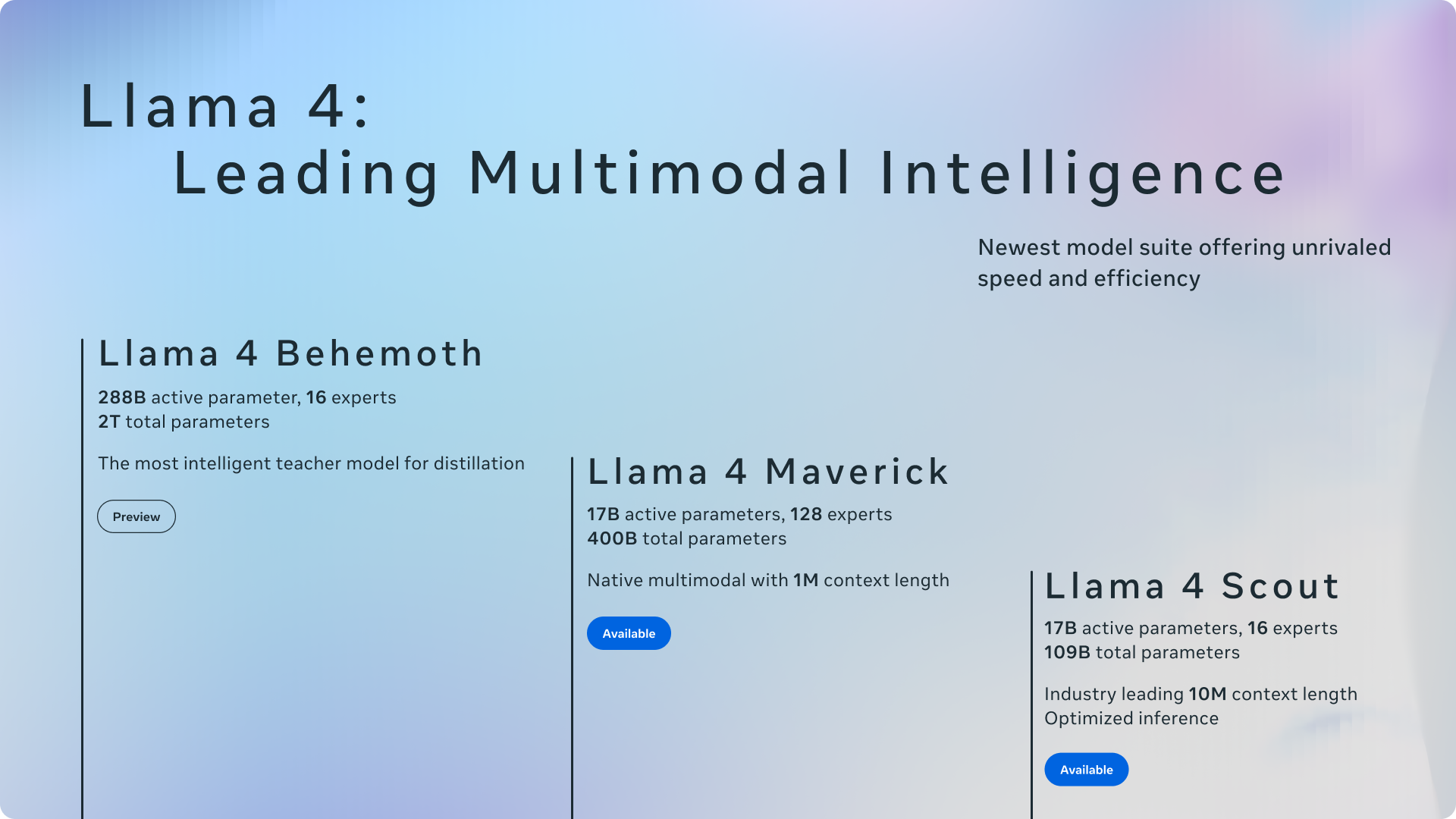

Meta tem anunciado oficialmente Seu conjunto mais avançado de modelos de inteligência artificial até o momento: a família Llama 4. Esta nova geração inclui o Llama 4 Scout e o Llama 4 Maverick, o primeiro dos modelos de peso aberto da Meta a oferecer multimodalidade nativa e suporte sem precedentes no comprimento do contexto. Esses modelos também marcam a incursão inicial do Meta no uso de uma arquitetura de mistura de especialistas (MOE). A Meta também forneceu uma prévia do LLAMA 4 Behemoth, um LLM altamente inteligente atualmente em treinamento, projetado para servir como professor para modelos futuros.

Esta atualização significativa para o ecossistema de lhama chega aproximadamente um ano após o lançamento de Lhama 3 em 2024ressaltando o compromisso da Meta de abrir a inovação no espaço da IA. Segundo a Meta, disponibilizar abertamente os modelos líderes disponíveis para promover o desenvolvimento de experiências personalizadas.

Scout and Maverick: modelos multimodais com arquitetura inovadora

LLAMA 4 Scout e Llama 4 Maverick são os modelos eficientes iniciais desta série. O LLAMA 4 Scout possui 17 bilhões de parâmetros ativos em 16 especialistas, enquanto o Llama 4 Maverick também apresenta 17 bilhões de parâmetros ativos, mas aproveita um pool maior de 128 especialistas em sua arquitetura MOE. Meta destaca a eficiência desse design, observando que o LLAMA 4 Scout pode se encaixar em uma única GPU H100 (com quantização INT4) e o lhama 4 Maverick em um único host H100, facilitando a implantação mais fácil.

A adoção de uma arquitetura da mistura de especialistas (MOE) é um avanço importante. Nos modelos MOE, apenas uma fração dos parâmetros totais é ativada para cada token, levando a um treinamento e inferência com mais eficiência de computação, proporcionando uma qualidade mais alta para um determinado orçamento de computação. Por exemplo, o Llama 4 Maverick tem 400 bilhões de parâmetros totais, mas apenas 17 bilhões são ativos durante o uso.

Tanto o LLAMA 4 Scout quanto o Llama 4 Maverick são nativamente multimodais, incorporando fusão precoce para processar perfeitamente os tokens de texto e visão em um backbone do modelo unificado. Isso permite o pré-treinamento conjunto em vastas quantidades de dados de texto, imagem e vídeo não marcados. A Meta também aprimorou o codificador da visão em Llama 4, construindo no metaclip, mas treinando -o separadamente ao lado de um modelo de lhama congelado para uma melhor adaptação.

Lhama 4 Behemoth: um modelo de professor com referências promissoras

A Meta forneceu um vislumbre da LLama 4 Behemoth, um modelo focado em professores com 288 bilhões de parâmetros ativos e quase dois trilhões de parâmetros totais em 16 especialistas. A Meta afirma que o Behemoth supera os principais modelos como GPT-4.5, Claude Sonnet 3.7 e Gemini 2.0 Pro em benchmarks focados em haste, como Math-500 e GPQA Diamond. Enquanto o LLama 4 Behemoth ainda está em treinamento e ainda não está disponível, ele desempenhou um papel crucial no “codistille” o modelo Maverick Llama 4, levando a melhorias significativas da qualidade.

Comprimento do contexto e recursos multilíngues

Um recurso de destaque dos modelos LLAMA 4 é o seu comprimento de contexto significativamente aumentado. O Scout Llama 4 lidera a indústria com uma janela de contexto de entrada de 10 milhões de token, um aumento dramático dos 128ks de Llama 3. Esse contexto estendido permite recursos avançados, como resumo de vários documentos e raciocínio sobre bases de código grandes. Ambos os modelos foram pré-treinados em um conjunto de dados maciço superior a 30 trilhões de tokens, mais que o dobro do lhama 3, e abrangendo mais de 200 idiomas, com mais de 100 idiomas com mais de 1 bilhão de tokens cada.

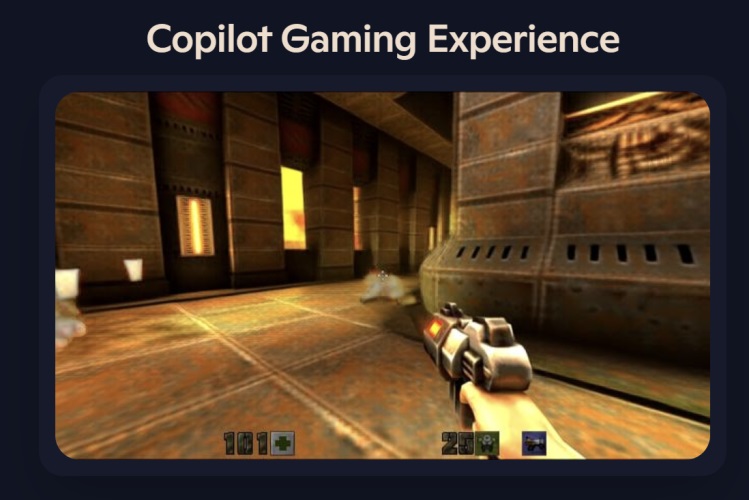

Integração em meta aplicativos e disponibilidade de desenvolvedores

Refletindo o compromisso da Meta de abrir a inovação, Llama 4 Scout e Llama 4 Maverick estão disponíveis para download hoje no llama.com e no rosto abraçando. A Meta também anunciou que esses modelos agora estão alimentando a Meta AI em aplicativos populares como WhatsApp, Messenger, Instagram Direct e no site da Meta.ai. Essa integração permite que os usuários experimentem diretamente os recursos dos novos modelos LLAMA 4.

A Meta enfatizou seu compromisso de desenvolver modelos úteis e seguros de IA. O LLAMA 4 incorpora as melhores práticas descritas em seu guia de uso do desenvolvedor de proteções de IA, incluindo mitigações em vários estágios de desenvolvimento. Eles também destacaram salvaguardas de origem aberta, como a Guarda da LLAMA e a rápida guarda para ajudar os desenvolvedores a identificar e evitar insumos e saídas prejudiciais.

Abordando a questão bem conhecida do viés no LLMS, a Meta afirmou que melhorias significativas foram feitas no lhama 4. O modelo se recusa a menos de instruções sobre tópicos políticos e sociais debatidos e demonstra uma resposta mais equilibrada em diferentes pontos de vista, mostrando desempenho comparável a Grok nessa área.