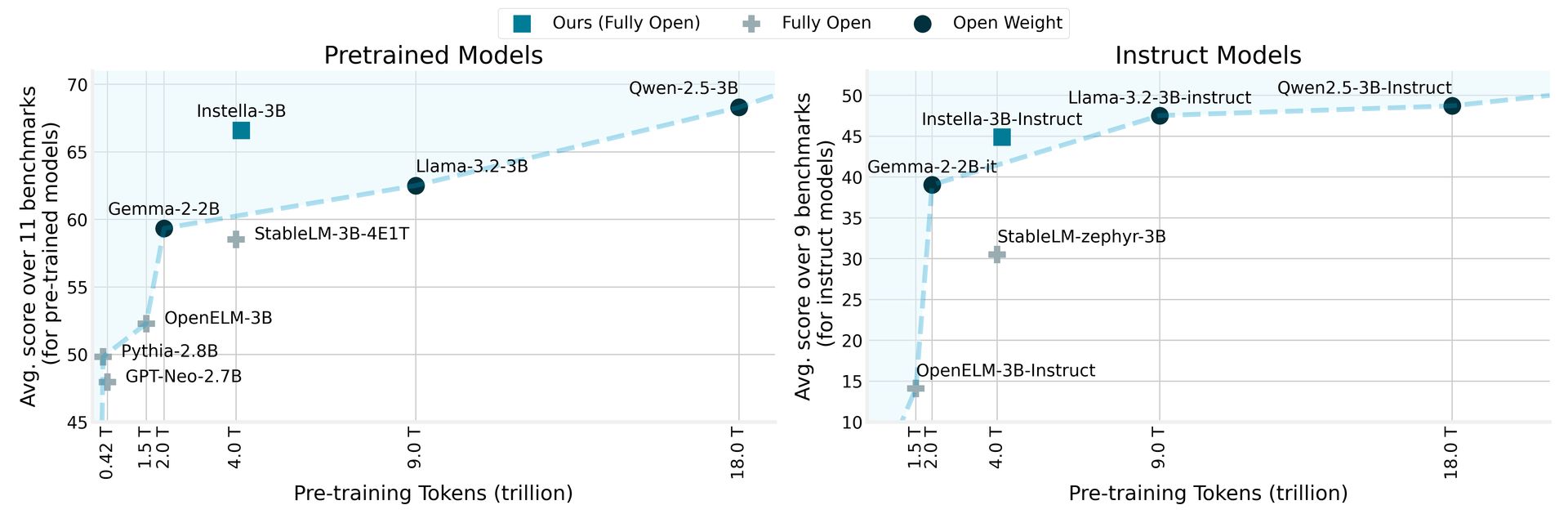

AMD tem revelado Instella, uma família de modelos de idiomas totalmente abertos com 3 bilhões de parâmetros, treinados do zero no AMD Instinct ™ MI300X GPUS. Os modelos Instella superem modelos abertos existentes de tamanhos semelhantes e competem efetivamente com os principais modelos de peso aberto, incluindo LLAMA-3.2-3B, GEMMA-2-2B e QWEN-2.5-3B, incluindo suas versões ajustadas por instruções.

A AMD revela a Instella: modelos de idiomas de código aberto superando os rivais

A Instella emprega uma arquitetura de transformadores autoregressivos que consiste em 36 camadas de decodificadores e 32 cabeças de atenção, permitindo que processe sequências longas de até 4.096 tokens. O modelo utiliza um vocabulário de aproximadamente 50.000 tokens, gerenciados pelo tokenizador OLMO, tornando -o adepto em gerar e interpretar texto em vários domínios.

O procedimento de treinamento para a Instella destaca a colaboração entre as inovações de hardware e software da AMD. Esse novo modelo se baseia nas bases estabelecidas pelos modelos anteriores de 1 bilhão de parâmetros da AMD, transitando o treinamento em GPUs MI250 de 64 AMD MI250 com 1,3 trilhão de tokens para usar o GPUS MI300X de 128 instintos com 4,15 trilhões de tokens para o modelo atual de 3 biluários de 3 bilões.

Ao comparar a Instella com modelos anteriores, a AMD relata que não apenas supera os modelos totalmente abertos existentes, mas também atinge o desempenho competitivo contra os modelos de peso aberto de ponta, marcando um marco significativo no campo de processamento de linguagem natural. Essa iniciativa se alinha ao compromisso da AMD em tornar a tecnologia avançada mais acessível e promover a colaboração e a inovação na comunidade de IA.

Preços da AMD RX 9000 podem fazer você repensar que a compra RTX 5090

Fases do modelo Instella e dados de treinamento

Este lançamento inclui várias versões dos modelos Instella, cada um representando diferentes estágios de treinamento:

| Modelo | Estágio | Dados de treinamento (tokens) | Descrição |

|---|---|---|---|

| Instella-3b-STAGE1 | Pré-treinamento (estágio 1) | 4,065 trilhões | Primeiro estágio pré-treinamento para desenvolver proficiência em linguagem natural. |

| Instella-3b | Pré-treinamento (estágio 2) | 57,575 bilhões | Segunda estágio pré-treinamento para aprimorar os recursos de solução de problemas. |

| Instella-3b-SFT | Sft | 8,902 bilhões (X3 épocas) | Ajuste fino supervisionado (SFT) para permitir os recursos de seguidores de instruções. |

| Instella-3b-Instruct | DPO | 760 milhões | Alinhamento às preferências humanas e aprimoramento dos recursos de bate -papo com otimização de preferência direta (DPO). |

No pipeline de treinamento em várias etapas, o primeiro estágio de pré-treinamento usou 4,065 trilhões de tokens de diversos conjuntos de dados, estabelecendo a compreensão da linguagem fundamental. O treinamento subsequente em 57.575 bilhões de tokens adicionais aumentou ainda mais o desempenho do modelo em tarefas e domínios variados.

Durante o ajuste fino supervisionado, a Instella-3b-SFT foi treinada com 8,9 bilhões de tokens, melhorando os recursos de resposta interativa. A fase final, Instella-3B-Instruct, foi submetida a treinamento de alinhamento com otimização direta de preferência usando 0,76 bilhões de tokens, garantindo que as saídas do modelo estejam alinhadas com valores e preferências humanas.

A AMD fez todos os artefatos associados aos modelos Instella totalmente abertos, incluindo pesos do modelo, configurações de treinamento, conjuntos de dados e código, promovendo colaboração e inovação na comunidade de IA. Esses recursos podem ser acessados via Abraçando o rosto cartões de modelo e Github Repositórios.

Crédito da imagem em destaque: AMD