Microsoft Corp. tem expandido Sua linha PHI de modelos de idiomas de código aberto com a introdução de dois novos algoritmos projetados para processamento multimodal e eficiência de hardware: PHI-4-mini e Phi-4-Multimodal.

Recursos Phi-4-Mini e Phi-4-Multimodal

O PHI-4-mini é um modelo somente de texto que incorpora 3,8 bilhões de parâmetros, permitindo que ele seja executado com eficiência em dispositivos móveis. É baseado em uma arquitetura de transformador somente para decodificador, que analisa apenas o texto que precede uma palavra para determinar seu significado, aumentando assim a velocidade de processamento e reduzindo os requisitos de hardware. Além disso, o PHI-4-mini utiliza uma técnica de otimização de desempenho conhecida como Atenção de Consultas Grupos (GQA) para diminuir o uso de hardware associado ao seu mecanismo de atenção.

Microsoft Phi-4 AI aborda matemática complexa com parâmetros 14B

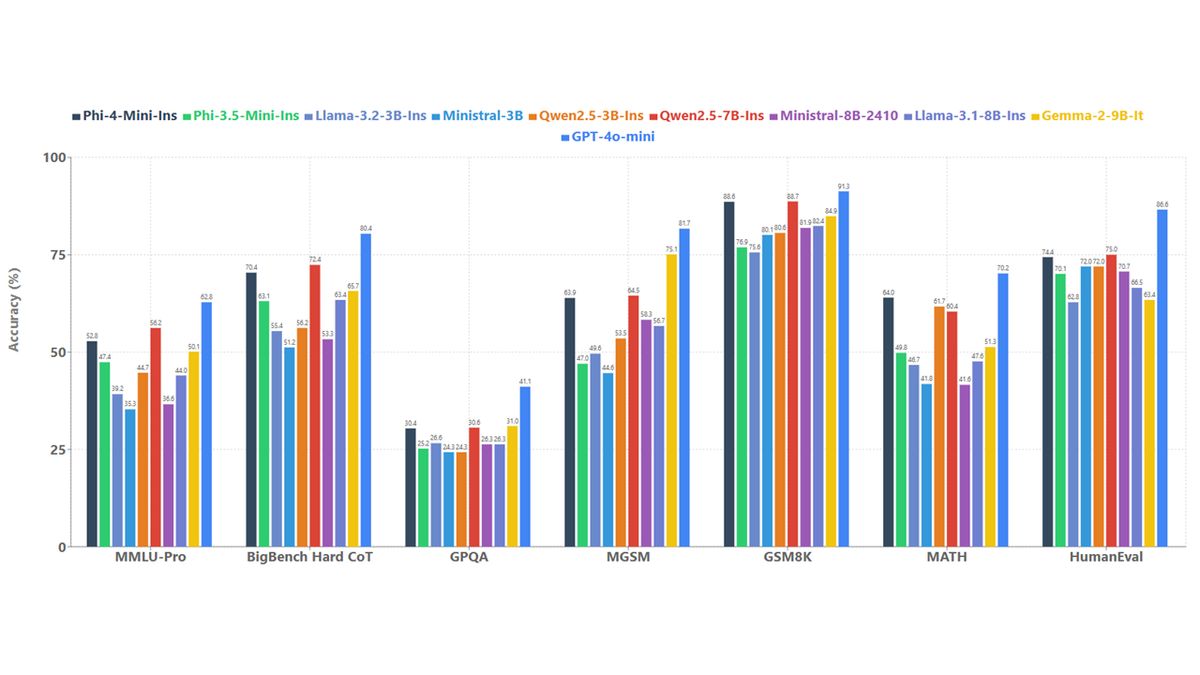

Este modelo é capaz de gerar texto, traduzir documentos e executar ações em aplicativos externos. A Microsoft afirma que o PHI-4-Mini se destaca em tarefas que requerem raciocínio complexo, como cálculos matemáticos e desafios de codificação, alcançando uma precisão significativamente melhorada em testes internos de referência em comparação com outros modelos de linguagem de tamanho semelhante.

O segundo modelo, PHI-4-Multimodal, é uma versão aprimorada do PHI-4-mini, com 5,6 bilhões de parâmetros. É capaz de processar entradas de texto, imagens, áudio e vídeo. Esse modelo foi treinado usando uma nova técnica chamada Mixture of Loras, que otimiza as capacidades do modelo para processamento multimodal sem extensas modificações em seus pesos existentes.

A Microsoft realizou testes de referência no PHI-4-Multimodal, onde obteve uma pontuação média de 72 no processamento de dados visuais, apenas tímido do GPT-4 do OpenAI, que obteve 73. O Gemini Flash 2.0 do Google LED com uma pontuação de 74,3. Nas tarefas visuais e de áudio combinadas, o Phi-4-Multimodal superou o flash gemini-2.0 “por uma margem grande” e superou o Internomni, especializado em processamento multimodal.

Phi-4-Multimodal e Phi-4-Mini são licenciados sob a licença do MIT e serão disponibilizados por meio de Abraçando o rostopermitindo uso comercial. Os desenvolvedores podem acessar esses modelos através Azure AI Foundry e Nvidia API Catalog para explorar seu potencial ainda mais.

O PHI-4-Multimodal é particularmente projetado para facilitar as interações naturais e com reconhecimento de contexto, integrando vários tipos de entrada em um único modelo de processamento. Inclui aprimoramentos, como um vocabulário maior, recursos multilíngues e maior eficiência computacional para execução no dispositivo.

O PHI-4-mini oferece desempenho impressionante em tarefas baseadas em texto, incluindo recursos de raciocínio e chamada de função, permitindo que ele interaja com interfaces de programação estruturada de maneira eficaz. A plataforma suporta seqüências de até 128.000 tokens.

Além disso, ambos os modelos foram submetidos a testes extensivos de segurança e segurança, liderados pela equipe interna do AI Red Azure (Airt) da Microsoft, que avaliou os modelos usando metodologias abrangentes de avaliação que abordam as tendências atuais em segurança cibernética, justiça e segurança do usuário.

A personalização e a facilidade de implantação são vantagens adicionais desses modelos, pois seus tamanhos menores permitem que sejam ajustados para tarefas específicas com demandas computacionais relativamente baixas. Exemplos de tarefas adequados para ajustes finos incluem tradução de fala e resposta a perguntas médicas.

Para mais detalhes sobre os modelos e suas aplicações, os desenvolvedores são incentivados a se referir ao Livro de receitas Phi Disponível no GitHub.

Crédito da imagem em destaque: Microsoft