Os grandes modelos de idiomas (LLMs) estão ficando mais inteligentes, mas também estão atingindo uma parede: lidar com longos peças de texto é lento e computacionalmente caro. Os mecanismos de atenção tradicionais – o núcleo de como a IA processa e se lembra de informações – lutam para escalar com eficiência, tornando os modelos caros para treinar e correr.

Agora, pesquisadores de Deepseek-AI e Pequim University ter introduzido uma abordagem de mudança de jogo chamada Atenção nativamente esparsa (NSA). Este novo método promete tornar os modelos de IA significativamente mais rápido, mais barato e mais eficientemantendo o mesmo nível de capacidade de raciocínio que as abordagens tradicionais.

Por que o problema de atenção da IA precisa de uma correção

Imagine ler um livro onde você tem que ter em mente todas as frases – é assim Plena atenção Os mecanismos funcionam na IA. Eles digitalizam e armazenam informações em sequências longas, mas à medida que o comprimento do contexto cresce (pense em milhares de palavras), essa abordagem se torna incrivelmente lenta e computacionalmente pesada.

Para abordar isso, os pesquisadores exploraram Atenção esparsa– que processa seletivamente apenas as informações mais importantes em vez de tudo. No entanto, métodos esparsos existentes têm grandes fraquezas:

- Eles são difíceis de treinar do zeromuitas vezes exigindo que os modelos aprendam primeiro com atenção antes de mudar para uma abordagem escassa.

- Eles não otimizam totalmente para hardware modernoo que significa que as melhorias teóricas de velocidade nem sempre se traduzem em eficiência no mundo real.

Como a NSA muda o jogo

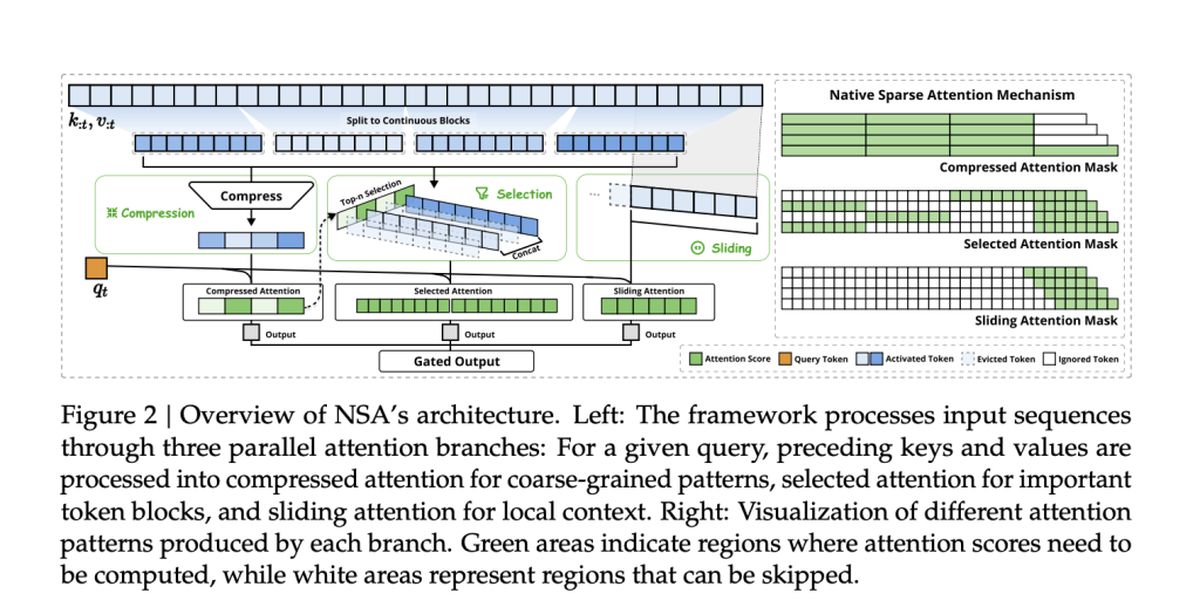

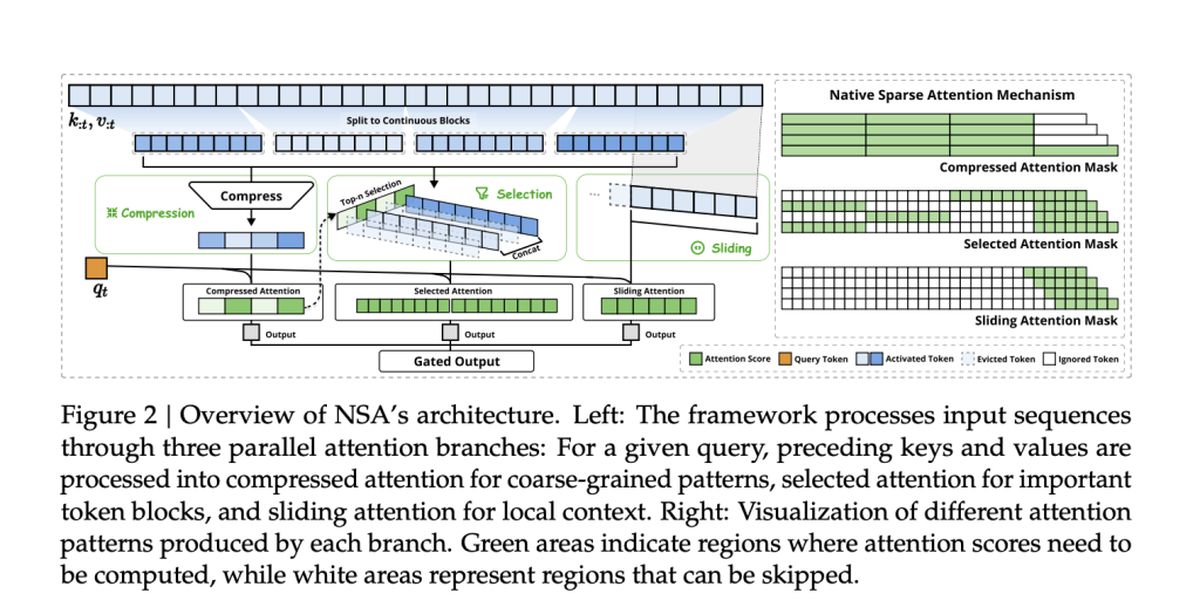

A equipe por trás da NSA, incluindo Jingyang Yuan, Huazuo Gao, Damai Dai e seus colegas, adotou uma nova abordagem. Seu método integra nativamente a esparsidade desde o inícioem vez de aplicá -lo como uma reflexão tardia.

NSA alcança isso com duas inovações importantes:

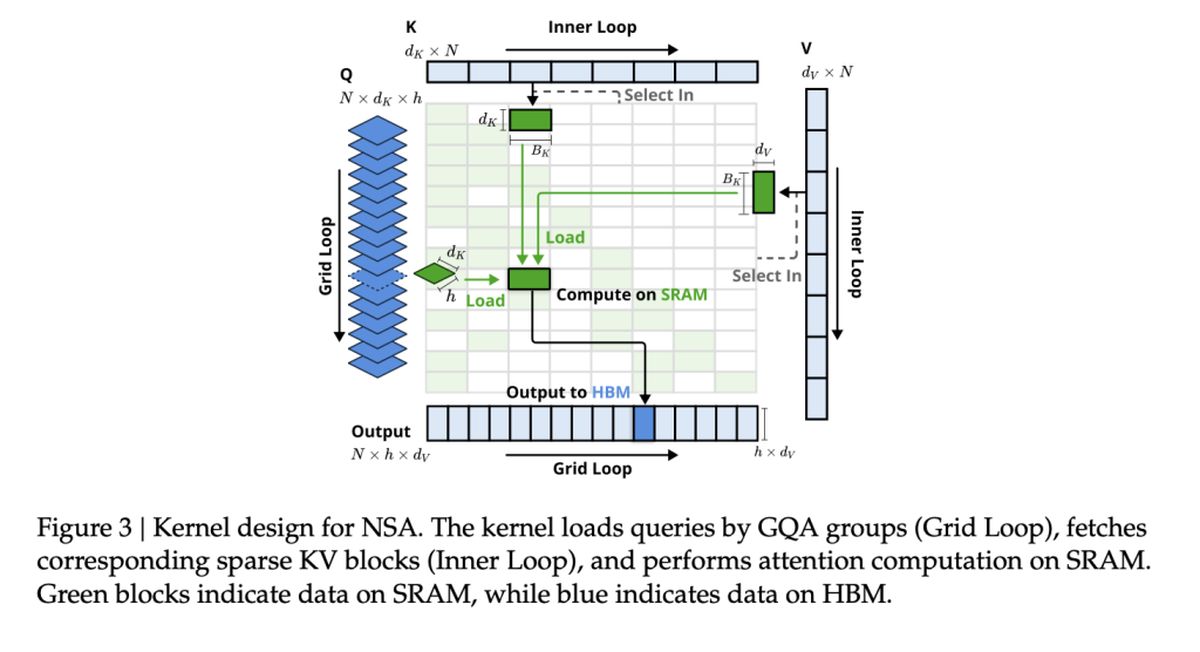

- Eficiência alinhada a hardware: A NSA é criada para maximizar o desempenho da GPU, evitando gargalos de memória e garantindo acelerações do mundo real.

- Treinabilidade de ponta a ponta: Ao contrário dos métodos esparsos anteriores, a NSA é totalmente treinável do zero, reduzindo os custos de treinamento sem perder a precisão.

Velocidade e precisão: a vantagem da NSA

Então, como a NSA se compara aos modelos tradicionais de atenção total? De acordo com o estudo, A NSA atinge até 11 × melhorias de velocidade Embora ainda correspondesse – ou até supere a atenção – atrelina a atenção nos principais benchmarks.

Algumas das maiores vitórias incluem:

- Processamento mais rápido: A NSA acelera a capacidade da IA de lidar com documentos longos, bases de código e conversas com várias turnos.

- Melhor raciocínio: Apesar de ser “escasso”, modelos da NSA combinar ou exceder Modelos de atenção total em tarefas de raciocínio de cadeia de pensamento.

- Custos mais baixos: Ao reduzir a computação sem sacrificar o desempenho, a NSA poderia tornar a IA avançada mais acessível para treinar e implantar.

Métodos de atenção esparsa existentes

Muitos mecanismos de atenção esparsa existentes tentam reduzir a sobrecarga computacional por podando tokens seletivamente ou otimizando o acesso à memória. No entanto, eles geralmente ficam aquém da implementação prática, seja porque introduzem componentes não transíveis ou não se alinham às arquiteturas modernas da GPU.

Por exemplo:

- ClusterKV e Magicpig Confie em técnicas discretas de cluster ou hash, que perturbam o fluxo do gradiente e dificultam o treinamento do modelo.

- H2O e Minference Aplique a escassez apenas durante estágios específicos de inferência, limitando as melhorias de velocidade em todo o pipeline.

- Missão e infllm Use os métodos de seleção do Blockwise, mas sua pontuação baseada em heurística geralmente resulta em taxas mais baixas de recall.

NSA aborda essas limitações, integrando a escassez nativamente—Enscando a eficiência no treinamento e na inferência, preservando a precisão do modelo. Isso significa Sem aproximações post-hoc ou compensações entre velocidade e capacidade de raciocínio.

O desempenho da NSA nas tarefas do mundo real

Para validar a eficácia da NSA, os pesquisadores o testaram em uma variedade de tarefas de IA, comparando seu desempenho com os modelos de atenção total tradicionais e métodos de atenção esparsa de ponta. Os resultados destacam a capacidade da NSA de combinar ou superar os modelos de atenção total, reduzindo significativamente os custos computacionais.

Desempenho geral de benchmark

NSA demonstrou forte precisão entre o conhecimento, o raciocínio e os benchmarks de codificaçãoincluindo:

- Mmlu & cmmlu: Combinando plena atenção em tarefas baseadas no conhecimento

- GSM8K & MATH: Superando a atenção total no raciocínio complexo

- Humaneval & MBPP: Oferecendo desempenho de codificação sólida

Entendimento de contorno de longo prazo

NSA se destaca em lidar com sequências de longo contexto em benchmarks como Longbench. Nas tarefas que requerem memória contextual profunda, a NSA mantinha:

- Alta recall nas tarefas de recuperação (Agulha em um haystack, controle de qualidade)

- Precisão estável no raciocínio multi-hop (HPQ, 2wiki, Govrpt)

Ganhos de velocidade do mundo real

As otimizações alinhadas a hardware na NSA levam a:

- 9 × velocidades de inferência mais rápidas para seqüências de 64 mil comprimentos

- 6 × eficiência de treinamento mais rápida comparado aos modelos de atenção total

- Consumo de largura de banda de memória reduzidatornando as aplicações de IA em larga escala mais viáveis