A inteligência artificial está melhorando para entender o mundo em três dimensões, mas um novo estudo sugere que muitos Os benchmarks 3D de modelo de grande idioma (LLM) podem não estar testando recursos 3D. Em vez disso, essas avaliações podem ser vítimas do que os pesquisadores chamam de problema de “tremenda 2D”-onde os modelos de IA treinados principalmente em imagens 2D podem superar os modelos 3D dedicados simplesmente renderizando nuvens em imagens.

Uma equipe da Universidade de Shanghai Jiao Tong, incluindo Jiahe Jin, Yanheng He e Mingyan Yang, descobriu em seu estudo: “Revisitando benchmarks 3D LLM: estamos realmente testando recursos 3D? ”, que muitas tarefas usadas para avaliar a IA 3D podem ser resolvidas com a mesma facilidade por modelos de linguagem de visão (VLMS)-os sistemas AI treinados principalmente em imagens e texto 2D. Isso levanta uma questão crucial: os benchmarks atuais estão realmente medindo o entendimento 3D ou eles estão apenas testando quão bem a IA pode processar renderizações 2D dos dados 3D?

Cheque 2D: o atalho que expõe benchmarks fracos

O problema decorre de como o 3D LLMS é avaliado. Muitos benchmarks existentes dependem P&R e tarefas de legendaonde uma IA é solicitada a descrever um objeto 3D ou responder a perguntas sobre ele. A suposição é que um IA treinada em 3D Deve ter um desempenho melhor do que um que entende apenas imagens 2D.

No entanto, os pesquisadores descobriram que VLMs como GPT-4O e QWEN2-VLque não foram projetados especificamente para tarefas 3D, poderiam Freqüentemente supera os modelos 3D de última geração—Pimplentemente olhando para as imagens 2D das nuvens de ponto. Isso sugere que esses benchmarks não estão realmente testando se a IA entende estruturas 3D, mas sim Quão bem pode inferir informações 3D de imagens planas.

Para demonstrar isso, a equipe se desenvolveu Vlm3dum método que converte nuvens de ponto 3D em imagens renderizadas antes de alimentá -las em um VLM. Quando testado nos principais benchmarks 3D da IA - incluindo 3d mm-vet, objaversexl-lvis, scanqa e sqa3d– VLM3D superou ou correspondeu modelos 3D líderes em muitas tarefas.

Por que algumas tarefas 3D são mais vulneráveis que outras

Enquanto o VLMS se destacou em tarefas como reconhecimento de objetos e descrição básica da cena, eles lutaram em tarefas que exigiam uma compreensão mais profunda de Relações espaciais, oclusões e consistência de várias vistas.

- Benchmarks de objeto 3D simples: Muitas tarefas de reconhecimento de objetos em benchmarks 3D podem ser facilmente resolvido usando imagens 2D. O estudo constatou que os VLMs poderiam corresponder ou exceder os modelos 3D nesses casos, provando que os benchmarks não estavam efetivamente testando o entendimento em 3D.

- Benchmarks de cena complexos: Tarefas que exigem a IA para entender ambientes 3D completos, como Perguntas e respostas no nível da cenaAssim, navegaçãoe raciocínio situacionaleram muito mais difíceis para os VLMs trairem. Aqui, o 3D LLMS tem um desempenho melhor, mostrando que essas tarefas dependem do verdadeiro raciocínio espacial em 3D.

Isso significa isso Nem todos os benchmarks 3D são falhos– mas muitos deles estão deixando de distinguir entre capacidade 3D genuína e truques de inferência 2D.

Quando os modelos 2D ficam presos

Uma das maiores fraquezas dos VLMs nas tarefas 3D vem de Seleção do ponto de vista– O fato de uma única imagem 2D capturar apenas parte de uma cena 3D.

Os pesquisadores testaram três abordagens de renderização diferentes Para avaliar quanto isso afeta o desempenho:

- Vista única: A abordagem mais simples, onde um objeto ou cena é renderizado de uma perspectiva fixa. O VLMS teve um melhor desempenho aquicomo eles poderiam extrair informações suficientes de apenas uma imagem.

- Multi-View: As imagens foram capturadas de quatro ângulos diferentesdando aos modelos de IA mais contexto. Surpreendentemente, VLMS não melhorou significativamente Comparado aos modelos de visão única, sugerindo que eles lutam para combinar várias perspectivas em um entendimento 3D unificado.

- Oracle View: A IA foi dada o melhor ponto de vista possível por responder a cada pergunta. Aqui, o VLMS teve um desempenho muito melhormas ainda não ficou aquém do 3D LLMS dedicado, mostrando que, mesmo quando recebeu imagens perfeitas, elas não têm verdadeiras habilidades de raciocínio em 3D.

Isso reforça a ideia de que VLMs não “entendem” 3D– Eles apenas se saem bem quando recebem as visualizações 2D certas.

O que precisa mudar

Para avaliar verdadeiramente os modelos de IA 3D, o estudo propõe quatro princípios -chave Para projetar melhores benchmarks:

- Dados 3D mais complexos: Em vez de usar nuvens simples de ponto de objeto, os benchmarks devem incluir Cenas 3D detalhadas e realistas com complexidade estrutural.

- Tarefas que exigem raciocínio 3D real: Em vez de apenas reconhecer objetos, a IA deve ser testada em tarefas que exigem entendimento espacialcomo prever superfícies ocultas ou raciocínio sobre interações de objetos.

- Desafios com consciência de contexto: As perguntas devem ser projetadas para se concentrar em Propriedades 3D exclusivasgarantindo que eles não possam ser respondidos usando apenas uma única imagem 2D.

- Melhores métricas de avaliação: Os benchmarks atuais geralmente confiam em Pontuações de similaridade de textoque não conseguem capturar Verdadeiro entendimento 3D. Em vez disso, os modelos de IA devem ser avaliados com base em sua capacidade de inferir profundidade, estrutura e relacionamentos de objetos no espaço tridimensional.

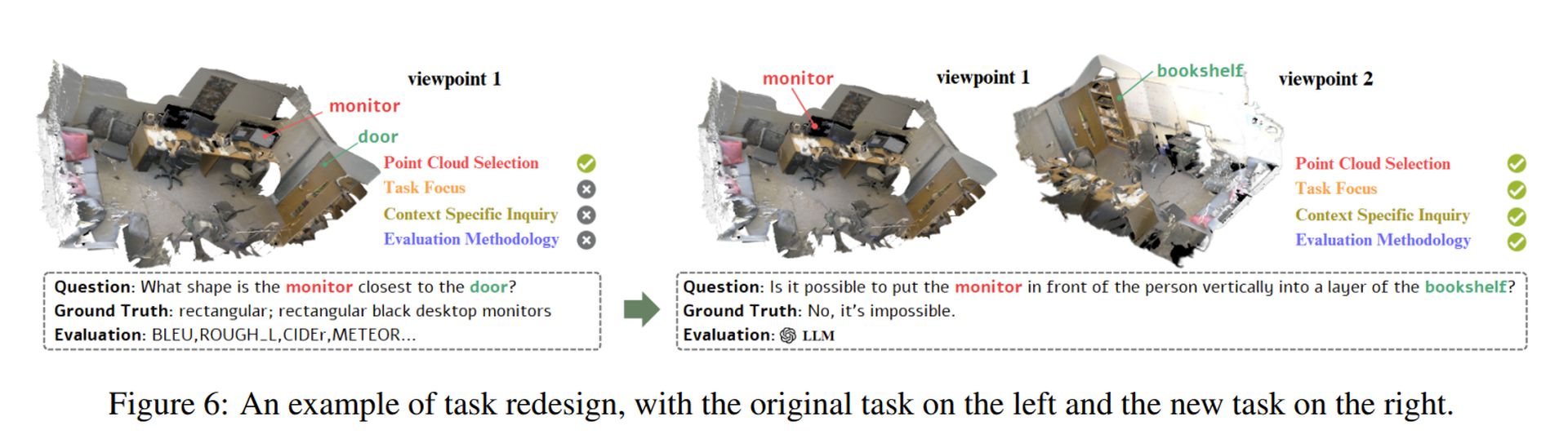

Os pesquisadores demonstraram como esses princípios poderiam ser aplicados por redesenhando uma tarefa falha (Veja a imagem acima). Sua abordagem garante que os modelos de IA devem realmente Processar estruturas 3D em vez de confiar em atalhos 2D.

Crédito da imagem em destaque: Sebastian Svenson/Unsplash