Um novo modelo de IA chamado S1, revelado Em um artigo divulgado em 2 de fevereiro, está atraindo atenção por seu desempenho econômico que rivaliza com o O1 Open, alcançando capacidades significativas a um custo de treinamento de apenas US $ 6.

Modelo de IA S1 surge como alternativa econômica ao Open’s O1’s O1

O modelo S1 atinge os níveis de desempenho próximos à última geração, utilizando infraestrutura mais simples. Ele aprimora os grandes modelos de linguagem (LLMs) durante a inferência, estendendo o “tempo de pensamento” através de intervenções, como substituir tags de terminais por prompts como “Espera”.

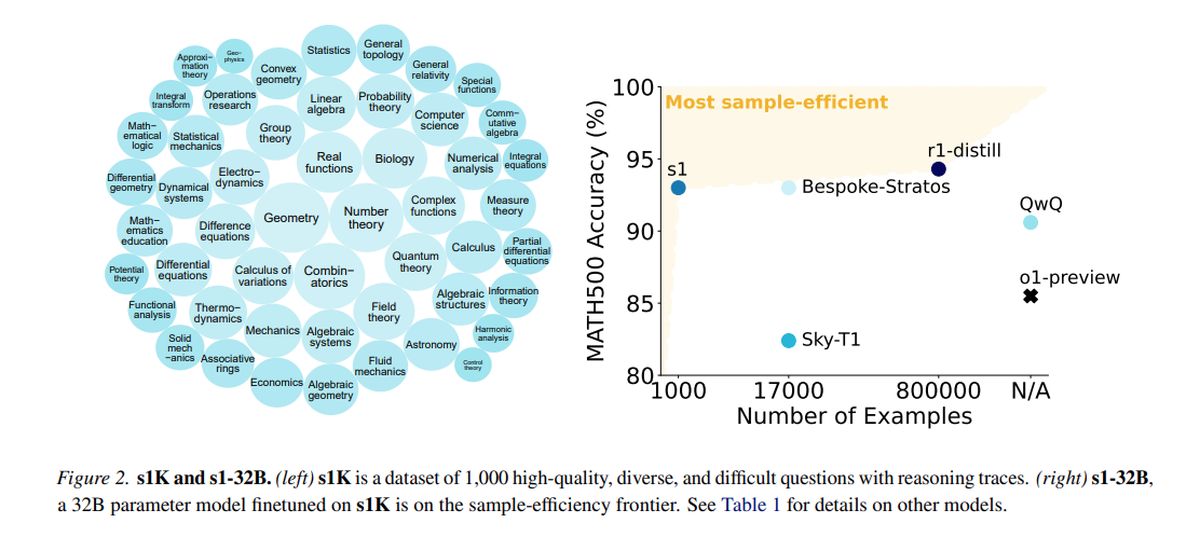

Treinado em um conjunto de dados destilado composto por 1.000 exemplos de alta qualidade da QWEN2.5, desenvolvida pela Alibaba Cloud, a S1 empregou 16 GPUs NVIDIA H100, com uma única corrida de treinamento com aproximadamente 26 minutos. O custo computacional total foi de cerca de US $ 6, permitindo experimentação mais frequente, mesmo para equipes com recursos limitados.

Enquanto organizações maiores como OpenAI e Antrópica dependem de uma extensa infraestrutura, inovações como S1 demonstram o potencial de progresso dentro de orçamentos restritos. No entanto, a introdução do S1 provocou preocupações sobre a “distalagem”, uma prática em que os modelos utilizam conjuntos de dados destilados de outros sistemas de IA, levantando questões éticas e legais que acenderam as discussões do setor.

Nos testes que medem as habilidades de matemática e codificação, o S1 tem um desempenho comparativamente aos principais modelos de raciocínio, como o Open O1 e o Deepseek R1. O modelo S1, incluindo seus dados e código de treinamento, está acessível no GitHub.

A equipe por trás do S1 começou com um modelo básico pronta para uso e o refinou através da destilação, um método para extrair recursos de raciocínio de um modelo de IA existente usando suas respostas. Especificamente, S1 é destilado do Google’s Gemini 2.0 Flash Thinking Experimental, representando uma abordagem semelhante usada pelos pesquisadores de Berkeley para desenvolver um modelo de raciocínio de IA por aproximadamente US $ 450 no mês passado.

A capacidade de as equipes de pesquisa menores inovarem no espaço da IA sem apoio financeiro substancial apresenta excitação e desafios. Surge a questão sobre a sustentabilidade das vantagens proprietárias em uma paisagem onde modelos caros podem ser replicados de maneira acessível.

O OpenAI expressou insatisfação, alegando que a Deepseek colheu dados incorretamente de sua API para fins de destilação do modelo. Os pesquisadores pretendiam criar uma abordagem direta que atinge o desempenho robusto do raciocínio e o “escala no tempo de teste”, permitindo que os modelos de IA se envolvam em análises mais profundas antes de responder.

A pesquisa S1 indica que os modelos de raciocínio podem ser destilados usando um conjunto de dados relativamente pequeno por meio de um método chamado ajuste fino supervisionado (SFT), que instrui o modelo de IA a imitar certos comportamentos dentro de um conjunto de dados. Esse método tende a ser mais econômico do que a abordagem de aprendizado de reforço em larga escala utilizada pela Deepseek para seu modelo R1.

O Google fornece acesso gratuito ao Gemini 2.0 Flash Thinking Experimental, embora o uso esteja sujeito a limites diários de taxas e seus termos proibem modelos de engenharia reversa para criar serviços concorrentes. O processo de treinamento S1 envolveu a curadoria de um conjunto de dados de 1.000 perguntas e respostas personalizadas, juntamente com os processos de raciocínio derivados do Gemini 2.0.

Após o treinamento, que levou menos de 30 minutos, o S1 demonstrou forte desempenho em benchmarks específicos de IA. Niklas Muennighff, pesquisador de Stanford envolvido no projeto, indicou que os recursos de computação necessários poderiam ser alugados hoje por cerca de US $ 20.

Os pesquisadores também implementaram uma técnica para aprimorar a precisão do S1, instruindo -a a “esperar” durante o raciocínio, estendendo assim seu tempo de pensamento e alcançando respostas ligeiramente aprimoradas.

Crédito da imagem em destaque: Google DeepMind/Unsplash