DeepSeek revelou mais uma grande contribuição para o cenário de IA de código aberto. Desta vez, é o Janus-Pro-7B: uma potência multimodal capaz de compreender e gerar imagens. De acordo com Rowan Cheungo novo modelo não apenas eclipsa o DALL-E 3 e o Stable Diffusion da OpenAI em benchmarks como GenEval e DPG-Bench, mas também mostra o mesmo espírito “disponível gratuitamente” que tornou o modelo R1 anterior do DeepSeek uma sensação viral. Enquanto isso, os investidores estão lutando para entender o aumento dos avanços em IA, com Ações da NVIDIA caindo mais de 17% ao meio-dia.

Poderá o Janus-Pro-7B ser o próximo grande disruptor num mercado tecnológico já turbulento?

O que é DeepSeek Janus-Pro-7B?

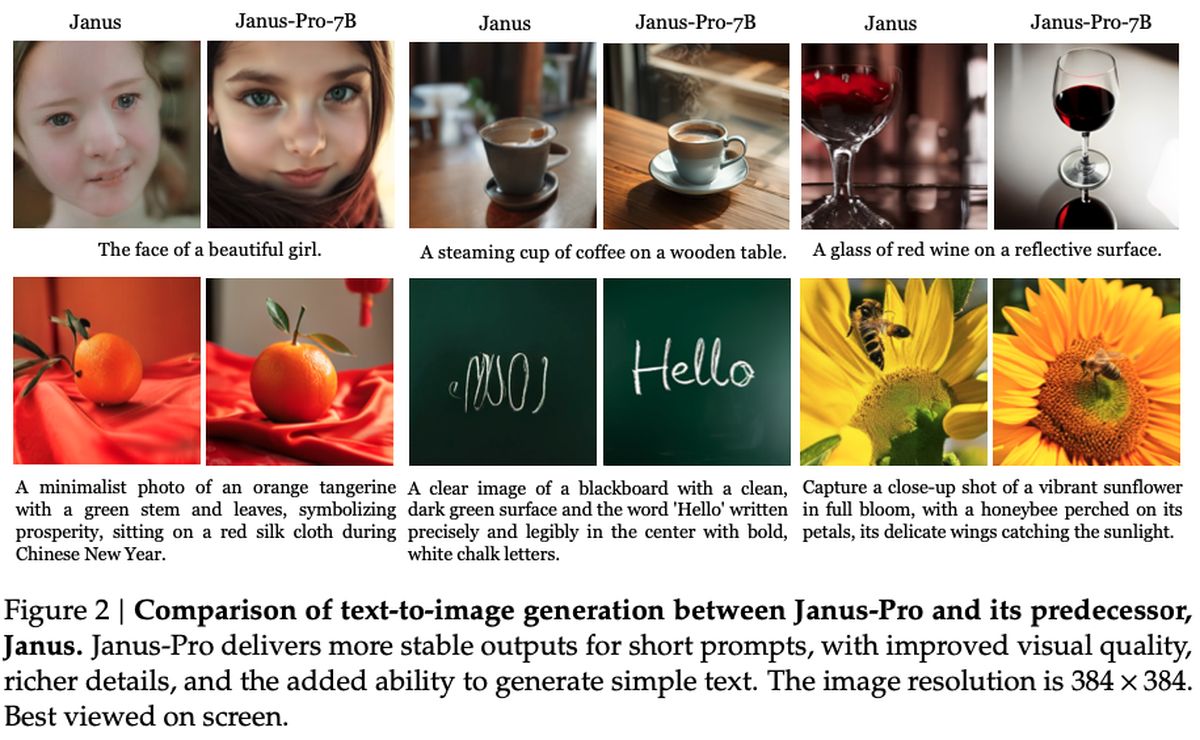

Nos bastidores, o Janus-Pro-7B procura preencher a lacuna entre o poderoso processamento de visão e a geração rápida de texto. Tomando emprestada uma nova abordagem de desacoplamento de seu codificador SigLIP-L, o sistema pode analisar rapidamente uma imagem 384 x 384 antes de entrar no modo de saída criativa. Ele corresponde, ou até mesmo supera, muitos modelos especializados no espaço – uma conquista especialmente impressionante, dado que também permanece extremamente fácil de personalizar e ampliar.

Os analistas apontam para a filosofia consistente do DeepSeek: mantê-lo de código aberto, priorizar a privacidade e superar os rivais baseados em assinatura. Janus-Pro-7B parece funcionar em todas as três frentes, estabelecendo marcas de alto desempenho enquanto preserva a acessibilidade que atraiu os fãs aos recursos offline do DeepSeek-R1.

Em termos puramente factuais, o Janus-Pro-7B está licenciado sob uma licença permissiva Estrutura do MITcom diretrizes de uso adicionais do DeepSeek. O modelo se integra a projetos downstream por meio de um repositório GitHub e supostamente usa apenas redução de resolução de 16x em seu pipeline de geração de imagens. Os indicadores atuais sugerem que a chegada do Janus-Pro-7B pode desencadear uma nova concorrência entre os desenvolvedores de IA, embora só o tempo dirá como esta última oferta gratuita afetará a zona de IA.

Como configurar o DeepSeek-R1 facilmente e gratuitamente (online e local)?

Como funciona?

Conforme detalhado no artigo de pesquisa publicado pela DeepSeek, o modelo emprega um codificador SigLIP-Large-Patch16-384, que divide cada imagem em patches de 16×16 com resolução de 384×384. Essa abordagem preserva detalhes refinados, ajudando o sistema a interpretar as imagens com mais precisão. Do lado da geração, o Janus-Pro usa um livro de códigos de 16.384 tokens para representar imagens em uma escala reduzida de 16x, permitindo reconstruções eficientes que rivalizam – se não superam – os modelos de difusão tradicionais em qualidade.

Dois adaptadores principais MLP (Multi-Layer Perceptron) conectam esses componentes de compreensão e geração, garantindo que os dados fluam suavemente entre as duas tarefas. Durante o treinamento, o modelo vê uma mistura de dados de imagem e texto, permitindo-lhe aprender como interpretar cenas visuais e produzir suas próprias imagens. As sessões normalmente levam de 7 a 14 dias em clusters de GPU de grande escala (para versões de parâmetros 1,5B e 7B), com desempenho testado em benchmarks como GQA (para compreensão visual) e VisualGen (para criação de imagens). O resultado é uma estrutura versátil que se destaca em tarefas multimodais, graças à sua arquitetura especializada, porém coesa.

Como usar o DeepSeek Janus-Pro-7B?

Começar a usar o Janus-Pro-7B é tão simples quanto acessar seu repositório oficial do GitHub, clonar ou baixar o código e instalar as dependências necessárias. O repositório inclui um README abrangente que orienta você na configuração de um ambiente Python, na extração dos pesos do modelo e na execução de scripts de amostra. Dependendo do seu hardware, você pode escolher entre o modo somente CPU ou aproveitar a aceleração da GPU para um desempenho mais rápido. De qualquer forma, o processo de instalação permanece simples, graças aos pré-requisitos bem documentados e às instruções passo a passo.

Depois que tudo estiver instalado e funcionando, você poderá fornecer prompts para geração de texto ou fornecer entradas de imagem para os recursos multimodais exclusivos do modelo. Os cadernos de amostra no repositório demonstram como gerar resultados criativos, aplicar transformações avançadas de imagem ou explorar cenários de “perguntas e respostas visuais”. Para usuários mais avançados, o design modular do repositório significa que você pode ajustar as camadas subjacentes, conectar seus próprios conjuntos de dados ou até mesmo empilhar o modelo junto com outras versões do DeepSeek, como R1.