Abraçar o rosto tem lançado Dois novos modelos de IA, SMOLVLM-256M e SMOLVLM-500M, alegando que eles são os menores do seu tipo capaz de analisar imagens, vídeos e texto em dispositivos com RAM limitada, como laptops.

Abraçando o rosto lança modelos de IA compactos para análise de imagem e texto

UM Modelo de linguagem pequena (SLM) é uma rede neural projetada para produzir texto de linguagem natural. O descritor “pequeno” se aplica não apenas às dimensões físicas do modelo, mas também à sua contagem de parâmetros, estrutura neural e volume de dados utilizados durante o treinamento.

SMOLVLM-256M e SMOLVLM-500M consistem em 256 milhões de parâmetros e 500 milhões de parâmetros, respectivamente. Esses modelos podem executar várias tarefas, incluindo a descrição de imagens e videoclipes, além de responder a perguntas sobre PDFs e seu conteúdo, como texto e gráficos digitalizados.

Sam Altman para informar funcionários sobre o Super AI no nível de doutorado

Para treinar esses modelos, o Hugging Face utilizou o caldeirão, uma coleção com curadoria de 50 conjuntos de dados de imagem e texto de alta qualidade, juntamente com o Docmatix, um conjunto de dados que compreende verificações de arquivos com legendas detalhadas. Ambos os conjuntos de dados foram criados por abraçar a equipe M4 do Face, focados nas tecnologias multimodais de IA.

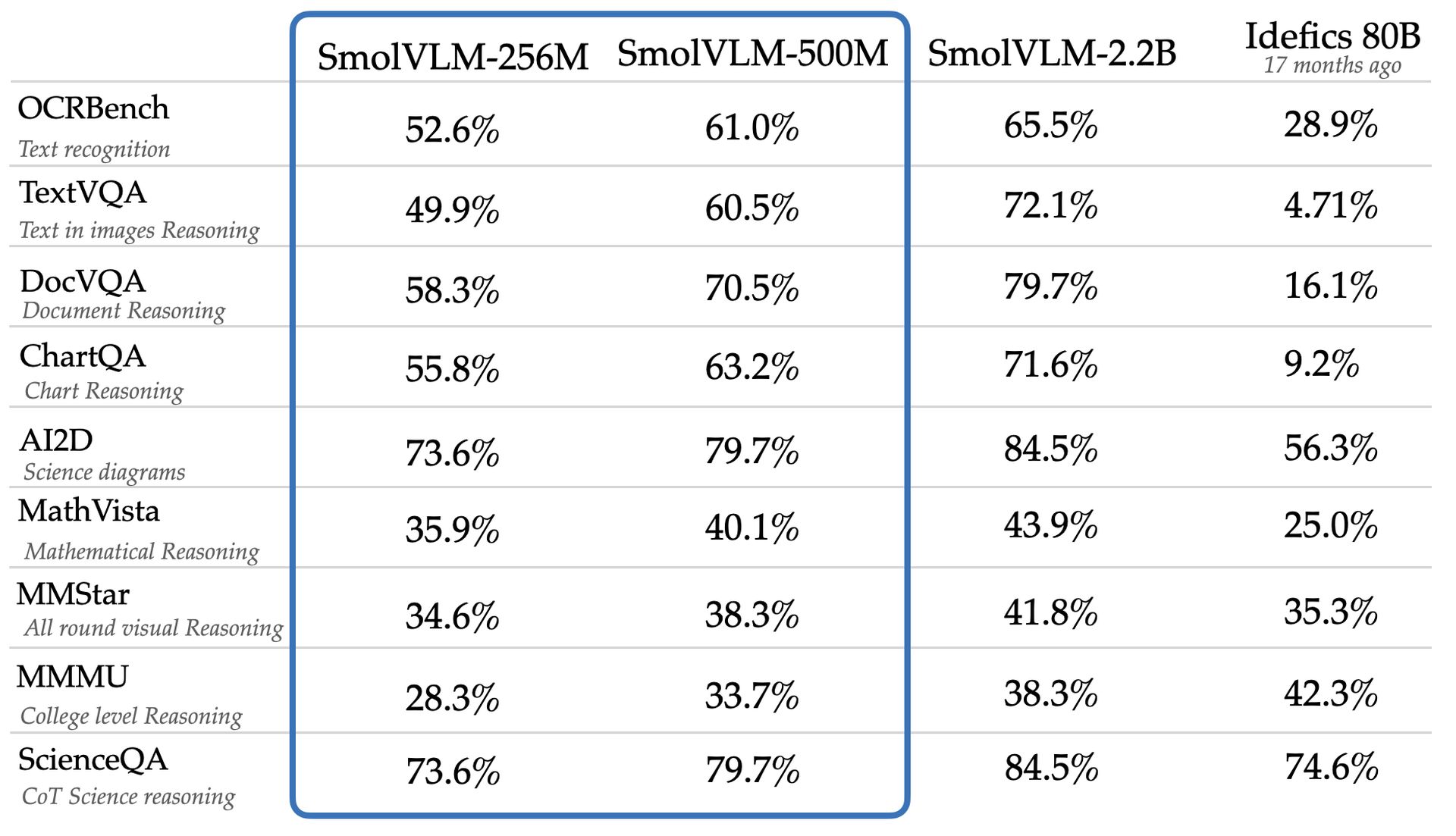

A equipe afirma que o SMOLVLM-256M e o SMOLVLM-500M superam um modelo significativamente maior, o IDEFICS 80B, em benchmarks como o AI2D, que avalia as habilidades dos modelos para analisar diagramas científicos de nível de ensino superior. Os novos modelos estão disponíveis para acesso e download na Web com uma licença Apache 2.0, que permite o uso irrestrito.

Apesar de sua versatilidade e custo-efetividade, modelos menores como SMOLVLM-256M e SMOLVLM-500M podem exibir limitações não observadas em modelos maiores. Um estudo do Google DeepMind, Microsoft Research e Mila Research Institute destacaram que os modelos menores geralmente se apresentam subotimalmente em tarefas complexas de raciocínio, potencialmente devido à sua tendência a reconhecer padrões no nível da superfície, em vez de aplicar conhecimento em novos contextos.

O modelo SMOLVLM-256M do Face Face opera com menos de um gigabyte da memória da GPU e supera o modelo Idefics 80B, um sistema 300 vezes maior, alcançando essa redução e aprimoramento dentro de 17 meses. Andrés Marafioti, um engenheiro de pesquisa de aprendizado de máquina da Hugging Face, observou que essa conquista reflete uma inovação significativa nos modelos de linguagem da visão.

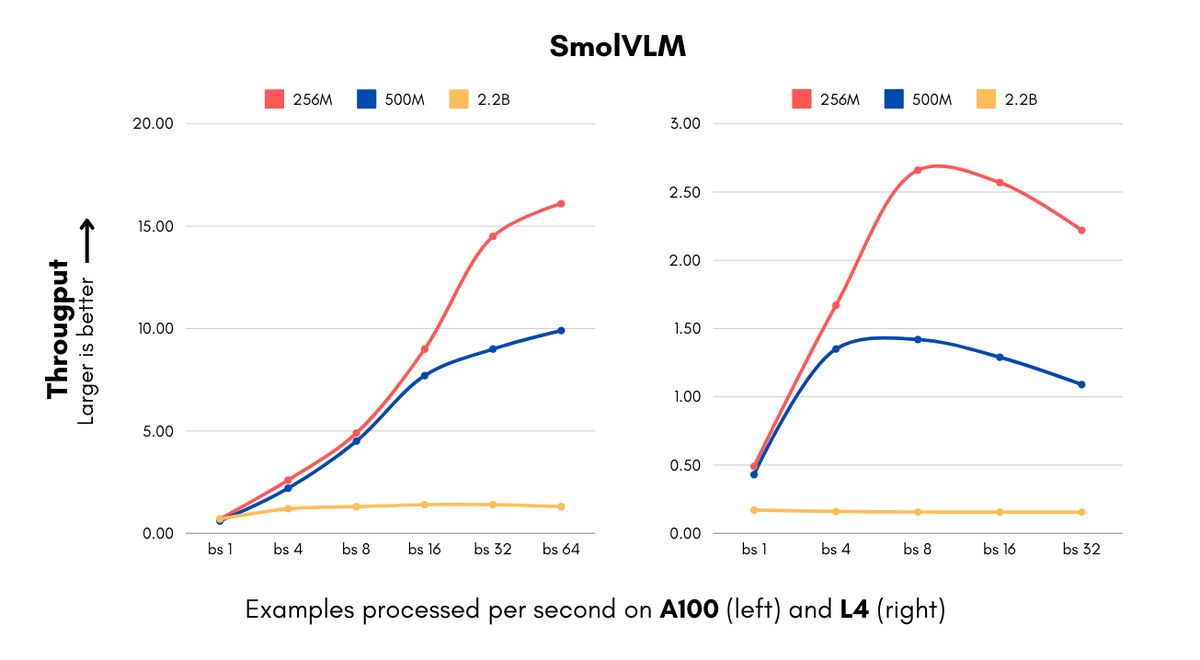

A introdução desses modelos é oportuna para empresas que enfrentam altos custos de computação associados às implementações de IA. Os modelos SMOLVLM são capazes de processar imagens e entender o conteúdo visual em velocidades sem precedentes para modelos de seu tamanho. A versão de 256m pode processar 16 exemplos por segundo, enquanto consome apenas 15 GB de RAM com um tamanho de lote de 64, levando a uma economia de custos considerável para empresas que lidam com grandes volumes de dados visuais.

A IBM formou uma parceria com o Hugging Face para incorporar o modelo de 256m em seu software de processamento de documentos, documentando. Como Marafioti explicou, mesmo organizações com recursos substanciais de computação podem se beneficiar do uso de modelos menores para processar eficientemente milhões de documentos a custos reduzidos.

Abraçando as reduções de tamanho obtidas no rosto, mantendo o desempenho por meio de avanços no processamento da visão e nos componentes do idioma, incluindo uma mudança de um codificador de 400m de parâmetro Vision para uma versão de parâmetros de 93m e o uso de técnicas agressivas de compressão de token. Essa eficiência abre novas possibilidades para startups e empresas menores, permitindo -lhes desenvolver produtos sofisticados de visão computacional mais rapidamente e reduzir seus custos de infraestrutura.

Os modelos SMOLVLM aprimoram os recursos além da economia de custos, facilitando novos aplicativos, como pesquisa avançada de documentos por meio de um algoritmo chamado Colipali, que cria bancos de dados pesquisáveis a partir de arquivos de documentos. De acordo com Marafioti, esses modelos quase correspondem ao desempenho dos modelos 10 vezes o seu tamanho, aumentando significativamente a velocidade da criação e pesquisa do banco de dados, tornando viável a pesquisa visual em toda a empresa para vários negócios.

Os modelos SMOLVLM desafiam a crença convencional de que modelos maiores são necessários para tarefas avançadas de linguagem de visão, com a versão de parâmetros de 500m atingindo 90% do desempenho de uma contrapartida de parâmetros de 2,2b nos benchmarks-chave. Marafioti destacou que esse desenvolvimento demonstra a utilidade de modelos menores, sugerindo que eles podem desempenhar um papel crucial para as empresas.

Crédito da imagem em destaque: Abraçando o rosto