Geração de texto para vídeo não é o que era há apenas alguns anos. Nós o transformamos em uma ferramenta com funcionalidades verdadeiramente futurísticas. Os usuários criam conteúdo para páginas pessoais, os influenciadores aproveitam-no para autopromoção e as empresas utilizam-no para tudo, desde publicidade e materiais educacionais até treinamento virtual e produção de filmes. A maioria dos sistemas de texto para vídeo são construídos na arquitetura de transformadores de difusão, que são a vanguarda no mundo da geração de vídeo. Essa tecnologia serve de base para serviços como Luma e Kling. No entanto, este estatuto só se solidificou em 2024, quando os primeiros transformadores de difusão para vídeo ganharam adopção no mercado.

O ponto de viragem veio com Lançamento da OpenAI de SORAapresentando fotos incrivelmente realistas que eram quase indistinguíveis da vida real. OpenAI mostrou que seu transformador de difusão poderia gerar conteúdo de vídeo com sucesso. Esta mudança validou o potencial da tecnologia e desencadeou uma tendência em toda a indústria: agora, aproximadamente 90% dos modelos atuais são baseados em transformadores de difusão.

A difusão é um processo fascinante que merece uma exploração mais aprofundada. Vamos entender como funciona a difusão, os desafios que a tecnologia do transformador enfrenta nesse processo e por que ela desempenha um papel tão significativo na geração de texto para vídeo.

Qual é o processo de difusão em GenAI?

No centro da geração de texto para vídeo e texto para imagem está o processo de difusão. Inspirados no fenômeno físico onde as substâncias se misturam gradualmente – como a tinta se difundindo na água – os modelos de difusão no aprendizado de máquina envolvem um processo de duas etapas: adicionar ruído aos dados e depois aprender a removê-lo.

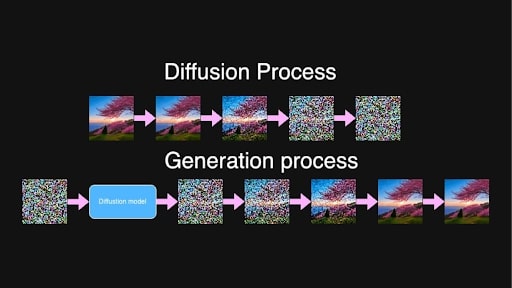

Durante o treinamento, o modelo captura imagens ou sequências de quadros de vídeo e adiciona ruído progressivamente ao longo de várias etapas até que o conteúdo original se torne indistinguível. Essencialmente, transforma-o em puro ruído.

Processos de difusão e geração para o prompt “Linda árvore de sakura soprada colocada na colina durante o nascer do sol”

Processos de difusão e geração para o prompt “Linda árvore de sakura soprada colocada na colina durante o nascer do sol”

Na geração de novos conteúdos, o processo funciona ao contrário. O modelo é treinado para prever e remover ruído em incrementos, focando em uma etapa intermediária aleatória de ruído entre dois pontos, t e t+1. Devido ao longo processo de treinamento, o modelo observou todas as etapas da progressão do ruído puro para imagens quase limpas e agora tem a capacidade de identificar e reduzir o ruído basicamente em qualquer nível.

A partir de ruído puro e aleatório, o modelo, guiado pelo texto de entrada, cria iterativamente quadros de vídeo que são coerentes e correspondem à descrição textual. Conteúdo de vídeo detalhado e de alta qualidade é o resultado desse processo muito gradual.

A difusão latente é o que torna isso computacionalmente possível. Em vez de trabalhar diretamente com imagens ou vídeos de alta resolução, os dados são compactados em um espaço latente por um codificador.

Isso é feito para reduzir (significativamente) a quantidade de dados que o modelo precisa processar, acelerando a geração sem comprometer a qualidade. Depois que o processo de difusão refina as representações latentes, um decodificador as transforma novamente em imagens ou vídeos de resolução total.

O problema com a geração de vídeo

Ao contrário de uma única imagem, o vídeo exige que os objetos e personagens permaneçam estáveis o tempo todo, evitando mudanças inesperadas ou mudanças na aparência. Todos nós já vimos as maravilhas de que a IA generativa é capaz, mas a perda ocasional de um braço ou uma expressão facial indistinguível estão dentro da norma. No vídeo, porém, os riscos são maiores; consistência é fundamental para uma sensação fluida.

Portanto, se um personagem aparecer no primeiro quadro vestindo uma roupa específica, essa roupa deverá ser idêntica em cada quadro subsequente. Qualquer mudança na aparência do personagem, ou qualquer “transformação” de objetos no fundo, quebra a continuidade e faz com que o vídeo pareça pouco natural ou até mesmo assustador.

Imagem fornecida pelo autor

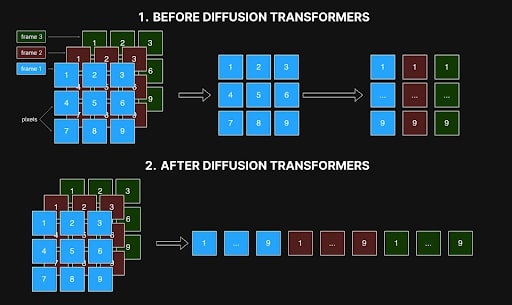

Os primeiros métodos abordavam a geração de vídeo processando quadros individualmente, com cada pixel em um quadro apenas referenciando seu pixel correspondente em outros. No entanto, esta abordagem quadro a quadro muitas vezes resultava em inconsistências, pois não conseguia capturar as relações espaciais e temporais entre os quadros, que são essenciais para transições suaves e movimentos realistas. Artefatos como mudança de cores, formas flutuantes ou recursos desalinhados são resultado dessa falta de coerência e diminuem a qualidade geral do vídeo.

Imagem fornecida pelo autor

Imagem fornecida pelo autor

O maior obstáculo para resolver isso foi a demanda computacional – e o custo. Para um vídeo de 10 segundos a 10 quadros por segundo, gerar 100 quadros aumenta a complexidade exponencialmente. Criar esses 100 quadros é cerca de 10.000 vezes mais complexo do que gerar um único quadro devido à necessidade de coerência precisa entre quadros. Esta tarefa requer 10.000 vezes mais em termos de memória, tempo de processamento e recursos computacionais, muitas vezes excedendo os limites práticos. Como você pode imaginar, o luxo de experimentar esse processo estava disponível para um grupo seleto do setor.

Isso é o que tornou o lançamento do SORA pela OpenAI tão significativo: eles demonstraram que os transformadores de difusão poderiam de fato lidar com a geração de vídeo, apesar da imensa complexidade da tarefa.

Como os transformadores de difusão resolveram o problema de autoconsistência na geração de vídeo

O surgimento dos transformadores de difusão resolveu vários problemas: eles permitiram a geração de vídeos de resolução e duração arbitrárias, ao mesmo tempo que alcançavam alta autoconsistência. Isso ocorre principalmente porque eles podem trabalhar com sequências longas, desde que caibam na memória, e devido ao mecanismo de autoatenção.

Na inteligência artificial, a autoatenção é um mecanismo que calcula os pesos de atenção entre os elementos de uma sequência, determinando o quanto cada elemento deve ser influenciado pelos outros. Ele permite que cada elemento em uma sequência considere todos os outros elementos simultaneamente e permite que os modelos se concentrem em partes relevantes dos dados de entrada ao gerar a saída, capturando dependências no espaço e no tempo.

Na geração de vídeo, isso significa que cada pixel em cada quadro pode se relacionar com todos os outros pixels em todos os quadros. Essa interconexão garante que objetos e personagens permaneçam consistentes durante todo o vídeo, do começo ao fim. Se um personagem aparecer em um quadro, a autoatenção ajuda a evitar alterações e a manter a aparência desse personagem em todos os quadros subsequentes.

Antes, os modelos incorporavam uma forma de autoatenção dentro de uma rede convolucional, mas esta estrutura limitava sua capacidade de alcançar a mesma consistência e coerência agora possível com transformadores de difusão.

Com atenção espaço-temporal simultânea em transformadores de difusão, entretanto, a arquitetura pode carregar dados de diferentes quadros simultaneamente e analisá-los como uma sequência unificada. Conforme mostrado na imagem abaixo, os métodos anteriores processavam interações dentro de cada quadro e apenas vinculavam cada pixel à sua posição correspondente em outros quadros (ver Figura 1). Esta visão restrita prejudicou a sua capacidade de capturar as relações espaciais e temporais essenciais para um movimento suave e realista. Agora, com os transformadores de difusão, tudo é processado simultaneamente (Figura 2).

Interação espaço-temporal em redes de difusão antes e depois de transformadores. Imagem fornecida pelo autor

Interação espaço-temporal em redes de difusão antes e depois de transformadores. Imagem fornecida pelo autor

Esse processamento holístico mantém detalhes estáveis entre os quadros, garantindo que as cenas não se transformem inesperadamente e se transformem em uma bagunça incoerente do produto final. Os transformadores de difusão também podem lidar com sequências de comprimento e resolução arbitrários, desde que caibam na memória. Com este avanço, a geração de vídeos mais longos é viável sem sacrificar a consistência ou a qualidade, abordando desafios que os métodos anteriores baseados em convolução não conseguiam superar.

A chegada dos transformadores de difusão remodelou a geração de texto para vídeo. Ele permitiu a produção de vídeos autoconsistentes e de alta qualidade em durações e resoluções arbitrárias. A autoatenção nos transformadores é um componente chave para enfrentar desafios como manter a consistência do quadro e lidar com relacionamentos espaciais e temporais complexos. O lançamento do SORA pela OpenAI comprovou essa capacidade, estabelecendo um novo padrão na indústria: agora, aproximadamente 90% dos sistemas avançados de texto para vídeo são baseados em transformadores de difusão, com grandes players como Luma, Clink e Runway Gen-3 liderando o mercado. mercado.

Apesar destes avanços impressionantes, os transformadores de difusão ainda consomem muitos recursos, exigindo quase 10.000 vezes mais recursos do que uma geração de imagem única, tornando o treinamento de modelos de alta qualidade ainda uma tarefa muito cara. No entanto, a comunidade de código aberto tomou medidas significativas para tornar esta tecnologia mais acessível. Projetos como Open-SORA e Open-SORA-Plan, bem como outras iniciativas como Mira Video Generation, Cog e Cog-2, abriram novas possibilidades para desenvolvedores e pesquisadores experimentarem e inovarem. Apoiados por empresas e instituições académicas, estes projetos de código aberto dão esperança de progresso contínuo e maior acessibilidade na geração de vídeo, beneficiando não apenas grandes corporações, mas também criadores independentes e entusiastas interessados em experimentar. Isto, como acontece com qualquer outro esforço conduzido pela comunidade, abre um futuro onde a geração de vídeo é democratizada, trazendo esta tecnologia poderosa para muito mais criativos explorarem.