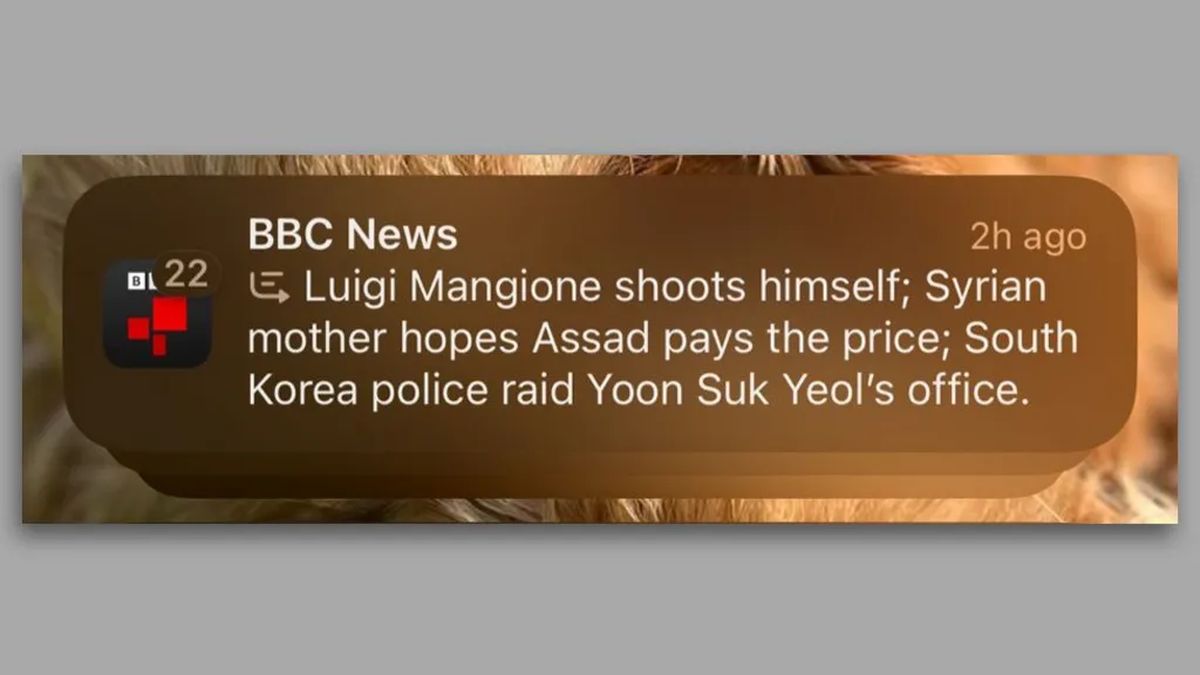

De acordo com um BBC relatório, a plataforma de IA recém-lançada da Apple, Apple Intelligence, enfrentou reação após anunciar incorretamente a morte de Luigi Mangione, um suspeito de assassinato. A notificação, enviada via iPhone na semana passada, resumiu um BBC relatar incorretamente, levando a críticas tanto de usuários quanto de organizações de mídia. Este incidente levanta questões significativas sobre a fiabilidade e precisão das informações geradas pela IA.

A ferramenta de IA da Apple relata incorretamente a notificação de morte do suspeito de assassinato

A Apple integrou o Apple Intelligence em seus sistemas operacionais, incluindo iOS 18 e macOS Sequoia. Entre suas funcionalidades, a plataforma oferece ferramentas generativas de IA projetadas para escrita e criação de imagens. Além disso, oferece uma função de categorização e resumo de notificações, com o objetivo de reduzir as distrações do usuário ao longo do dia. No entanto, a recente notificação falsa destaca potenciais imprecisões e deficiências deste novo recurso, deixando os utilizadores perplexos e preocupados com a integridade das informações partilhadas.

Numa notificação datada de 13 de dezembro de 2024, os usuários do iPhone receberam uma mensagem dizendo: “Luigi Mangione dá um tiro em si mesmo”, ao lado de outros dois resumos de notícias de última hora. Esta notificação errada rapidamente chamou a atenção, especialmente porque relatou incorretamente um detalhe crucial sobre Mangione, que é acusado de matar o ex-CEO da UnitedHealthcare, Brian Thompson, em 4 de dezembro. BBCque não publicou nenhuma informação sobre Mangione supostamente ter atirado em si mesmo, apresentou queixa à Apple. Desde então, a rede pediu que a Apple reconsiderasse sua ferramenta generativa de IA.

O problema subjacente parece resultar dos modelos de linguagem (LLMs) utilizados pela Apple Intelligence. De acordo com A ruaKomninos Chatzipapas, diretor da Orion AI Solutions, “LLMs como GPT-4o… não têm realmente nenhuma compreensão inerente do que é verdade e do que não é.” Esses modelos prevêem estatisticamente as próximas palavras com base em vastos conjuntos de dados, mas esse método pode resultar em conteúdo que parece confiável e deturpa os fatos. Nesse caso, Chatzipapas especulou que a Apple pode ter treinado inadvertidamente seu modelo de resumo com exemplos semelhantes em que indivíduos atiraram em si mesmos, gerando a manchete enganosa.

As implicações deste incidente vão além das práticas internas da Apple. A Repórteres Sem Fronteiras instou a empresa a remover o recurso de resumo, enfatizando a gravidade da divulgação de informações imprecisas vinculadas a meios de comunicação confiáveis. Vincent Berthier, dos Repórteres Sem Fronteiras articulado preocupações com a desinformação gerada pela IA que prejudica a credibilidade das fontes de notícias. Ele afirmou: “As IAs são máquinas de probabilidade e os fatos não podem ser decididos por meio de um lançamento de dados”. Isto reforça o argumento de que os modelos de IA carecem atualmente da maturidade necessária para garantir uma divulgação fiável de notícias.

Não permita que a IA lucre com a dor e o sofrimento das famílias

Este incidente não é isolado. Desde o lançamento do Apple Intelligence nos EUA em junho, os usuários relataram mais imprecisões, incluindo uma notificação informando que o primeiro-ministro israelense, Benjamin Netanyahu, havia sido preso. Embora o Tribunal Penal Internacional tenha emitido um mandado de detenção para Netanyahu, a notificação omitiu um contexto crucial, exibindo apenas a frase “Netanyahu preso”.

A controvérsia em torno da Apple Intelligence revela desafios relacionados à autonomia dos editores de notícias na era da IA. Embora algumas organizações de mídia empreguem ativamente ferramentas de IA para redação e reportagem, os usuários do recurso da Apple recebem resumos que podem deturpar os fatos, ao mesmo tempo que aparecem sob o nome do editor. Este princípio poderá ter implicações mais amplas na forma como a informação é comunicada e percebida na era digital.

A Apple ainda não respondeu às perguntas sobre seu processo de revisão ou quaisquer medidas que pretende tomar em relação ao da BBC preocupações. O panorama atual da tecnologia de IA, moldado significativamente pela introdução de plataformas como ChatGPT, estimulou a inovação rápida, mas também cria um terreno fértil para imprecisões que podem enganar o público. À medida que prosseguem as investigações sobre o conteúdo gerado pela IA e as suas implicações, a importância de garantir a fiabilidade e a precisão torna-se cada vez mais primordial.

Crédito da imagem em destaque: Maxim Hopman/Unsplash