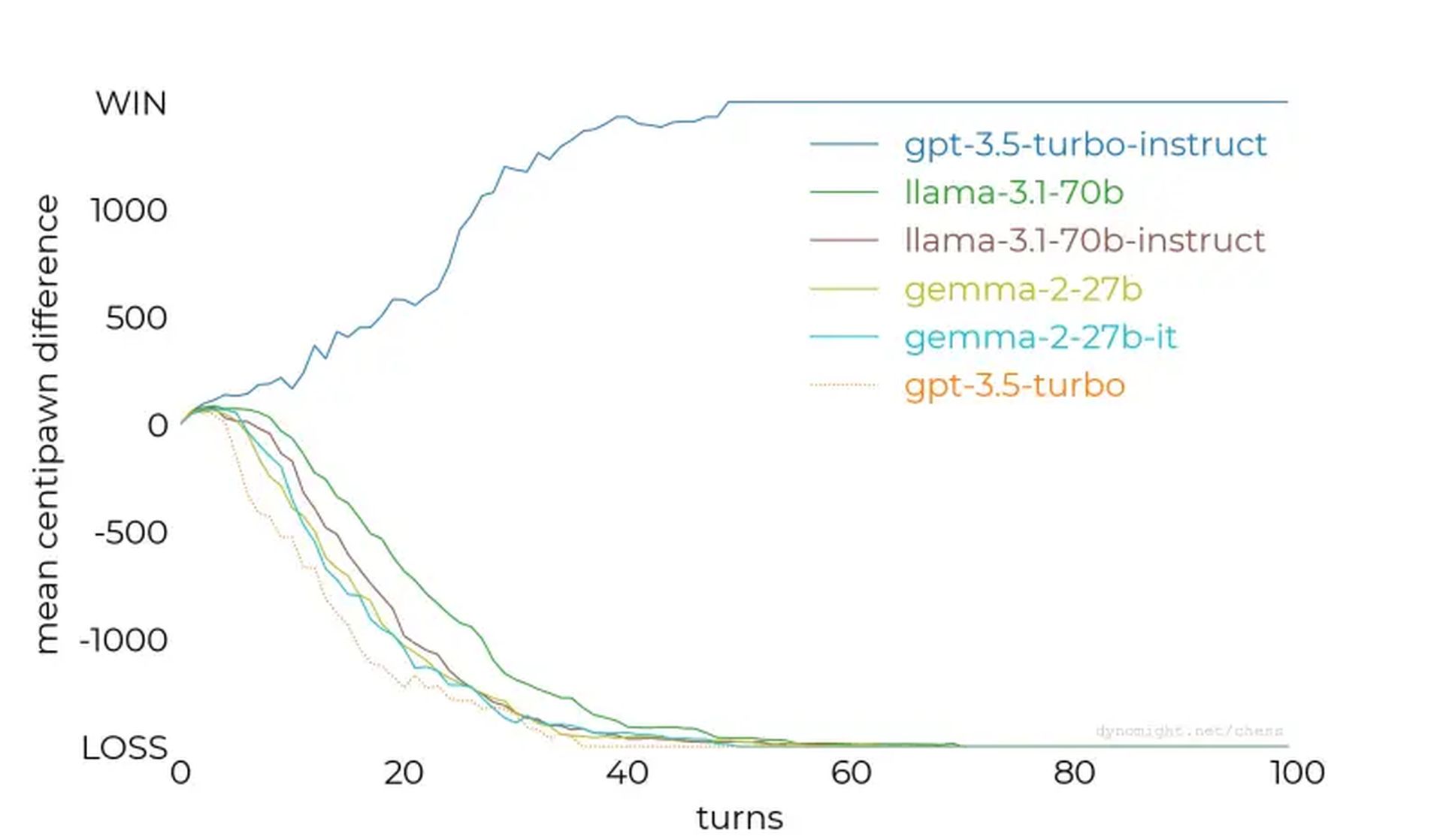

- Nem todos os LLMs são iguais: GPT-3.5-turbo-instruct se destaca como o modelo de jogo de xadrez mais capaz testado.

- O ajuste fino é crucial: O ajuste de instruções e a exposição direcionada do conjunto de dados melhoram drasticamente o desempenho em domínios específicos.

- Xadrez como referência: O experimento destaca o xadrez como uma referência valiosa para avaliar as capacidades do LLM e refinar os sistemas de IA.

Os modelos de linguagem de IA podem jogar xadrez? Essa questão desencadeou uma investigação recente sobre a forma como os grandes modelos de linguagem (LLMs) lidam com tarefas de xadrez, revelando insights inesperados sobre os seus pontos fortes, fracos e metodologias de treino.

Embora alguns modelos tenham fracassado até mesmo nos motores de xadrez mais simples, outros – como o GPT-3.5-turbo-instruct da OpenAI – mostraram um potencial surpreendente, apontando para implicações intrigantes para o desenvolvimento da IA.

Testando LLMs em mecanismos de xadrez

Os pesquisadores testaram vários LLMs pedindo-lhes que jogassem xadrez como grandes mestres, fornecendo estados de jogo em notação algébrica. O entusiasmo inicial centrou-se em saber se os LLMs, treinados em vastos corpora de texto, poderiam aproveitar o conhecimento incorporado do xadrez para prever movimentos de forma eficaz.

No entanto, os resultados mostraram que nem todos os LLMs são criados iguais.

O estudar começou com modelos menores como lhama-3.2-3bque possui 3 bilhões de parâmetros. Após 50 partidas contra o nível de dificuldade mais baixo do Stockfish, o modelo perdeu todas as partidas, não conseguindo proteger suas peças ou manter uma posição favorável no tabuleiro.

Os testes foram escalados para modelos maiores, como lhama-3.1-70b e sua variante ajustada para instrução, mas eles também tiveram dificuldades, mostrando apenas pequenas melhorias. Outros modelos, incluindo Qwen-2.5-72b e comando-r-v01continuou a tendência, revelando uma incapacidade geral de compreender até mesmo estratégias básicas de xadrez.

GPT-3.5-turbo-instruct foi o vencedor inesperado

O ponto de viragem veio com GPT-3.5-turbo-instruçãoque se destacou contra o Stockfish – mesmo quando o nível de dificuldade do motor foi aumentado. Ao contrário de equivalentes orientados para bate-papo, como gpt-3.5-turbo e gpt-4oo modelo ajustado por instrução produziu consistentemente movimentos vencedores.

Por que alguns modelos se destacam enquanto outros falham?

As principais conclusões da pesquisa ofereceram insights valiosos:

- O ajuste de instruções é importante: Modelos como o GPT-3.5-turbo-instruct se beneficiaram do ajuste fino do feedback humano, o que melhorou sua capacidade de processar tarefas estruturadas como o xadrez.

- Exposição do conjunto de dados: Especula-se que os modelos de instrução podem ter sido expostos a um conjunto de dados mais rico de jogos de xadrez, garantindo-lhes um raciocínio estratégico superior.

- Desafios de tokenização: Pequenas nuances, como espaços incorretos nos prompts, atrapalharam o desempenho, destacando a sensibilidade dos LLMs à formatação de entrada.

- Influências de dados concorrentes: O treinamento de LLMs em diversos conjuntos de dados pode diluir sua capacidade de excelência em tarefas especializadas, como xadrez, a menos que seja contrabalançado com um ajuste fino direcionado.

À medida que a IA continua a melhorar, estas lições informarão estratégias para melhorar o desempenho do modelo em todas as disciplinas. Quer se trate de xadrez, compreensão de linguagem natural ou outras tarefas complexas, compreender como treinar e ajustar a IA é essencial para desbloquear todo o seu potencial.

Crédito da imagem em destaque: Piotr Makowski/Remover respingo