Em um mundo dominado por modelos de IA inchados que vivem na nuvem, a Mistral AI está invertendo o roteiro. A startup francesa acaba de desencadeado dois novos modelos – Ministral 3B e 8B – projetados para rodar em dispositivos de ponta.

Les Ministraux: Ministral 3B e 8B

As novas ofertas da Mistral, apelidadas de “Les Ministraux”, podem parecer um filme de arte francês, mas estes modelos estão preparados para abalar o mundo da IA. Com apenas 3 bilhões e 8 bilhões de parâmetros respectivamente, a família Ministraux tem tudo a ver com eficiência. Esqueça aqueles modelos de IA que consomem muitos recursos e que exigem um data center para funcionar.

“Nossos clientes e parceiros mais inovadores têm solicitado cada vez mais inferências locais que priorizem a privacidade para aplicações críticas”, explicou Mistral.

Comprimento do contexto como nunca antes

É aqui que as coisas ficam realmente picantes: os modelos 3B e 8B podem lidar com uma janela de contexto de 128.000 tokens. Isso é o equivalente a um livro de 50 páginas. Para efeito de comparação, mesmo OpenAI’s Turbo GPT-4 limita-se à mesma contagem de tokens, e isso não é pouca coisa.

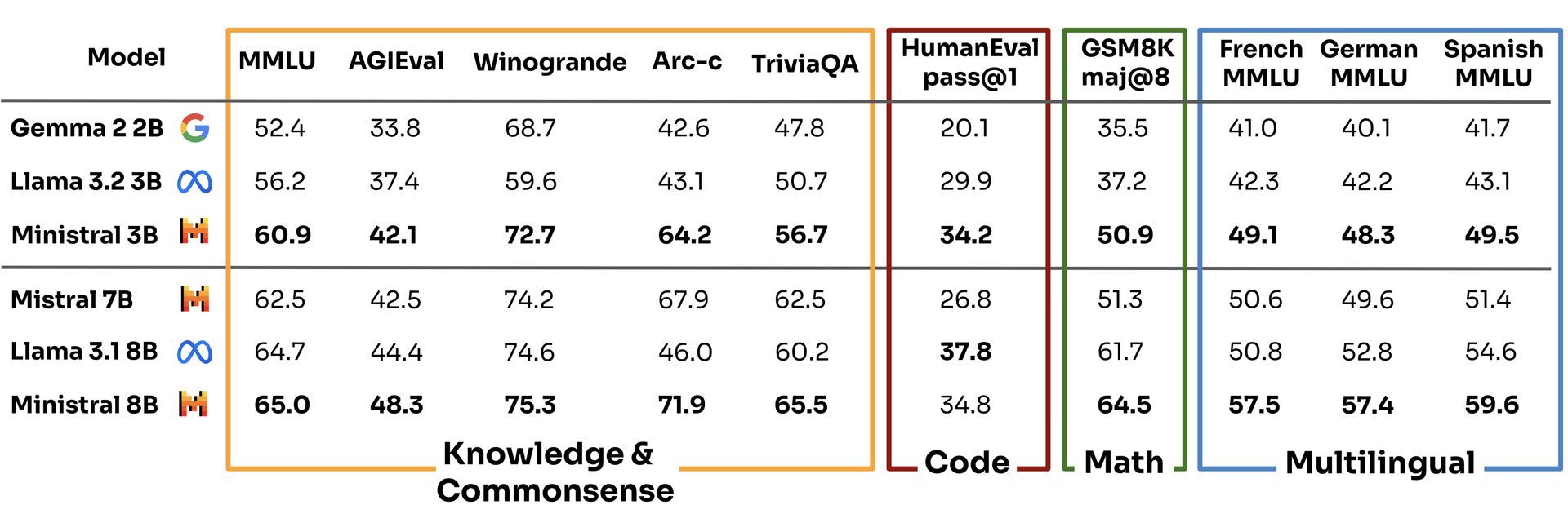

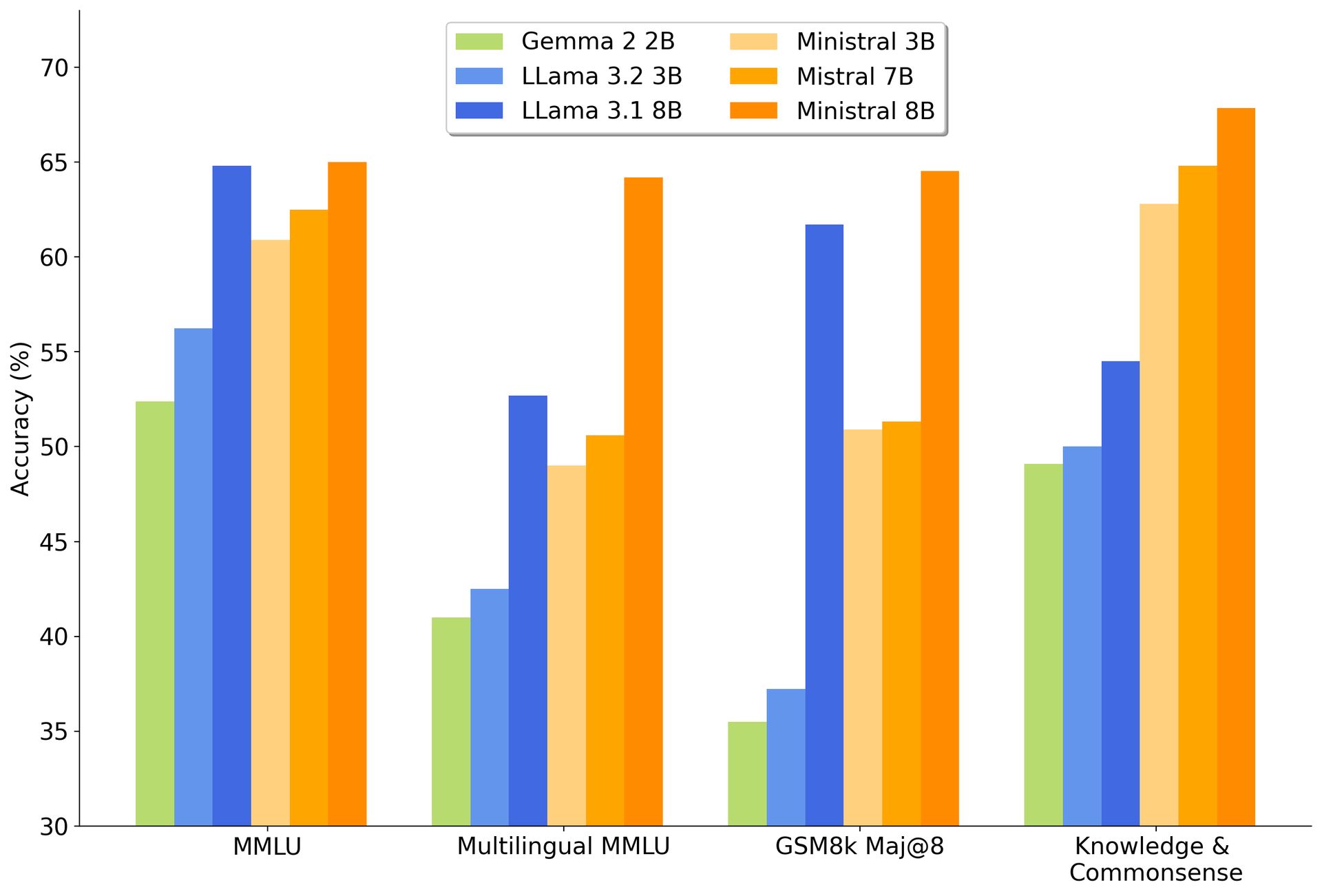

Com esse tipo de capacidade, os modelos Ministraux não apenas superam seu antecessor, o Mistral 7B – eles também estão comendo o do Google Gema 2 2B e Modelos de lhama da Meta para o café da manhã.

De acordo com os próprios benchmarks da Mistral, o modelo 3B obteve pontuação de 60,9 na avaliação Multi-task Language Understanding, deixando concorrentes como Llama 3.2 3B e Gemma 2 2B atrás de 56,2 e 52,4, respectivamente.

Nada mal para um modelo “menor”, certo?

Enquanto todos os demais no mundo da IA lutam para criar modelos maiores e mais malvados que consomem energia, Mistral está jogando um jogo diferente. Ao funcionar em dispositivos locais, Les Ministraux elimina a necessidade de servidores em nuvem massivos e, ao fazê-lo, oferece uma opção muito mais ecológica. É uma medida que se alinha perfeitamente com a crescente pressão sobre as empresas de tecnologia para serem mais conscientes do ponto de vista ambiental. A IA pode ser o futuro, mas ninguém quer que esse futuro venha às custas do planeta.

Há também o ângulo da privacidade. Com tudo funcionando localmente, seus dados permanecem no seu dispositivo, o que é uma grande vitória para setores como saúde e finanças, que estão cada vez mais sob o microscópio pela forma como lidam com informações confidenciais. Você pode pensar nisso como uma IA sem espionagem – uma mudança refrescante em um mundo onde cada aplicativo parece estar coletando mais dados do que a NSA.

O plano mestre de Mistral: construir, interromper, repetir

Mas não vamos nos enganar: Mistral não está fazendo isso apenas para um bem maior. A empresa, cofundada por ex-alunos da Meta e DeepMind do Google, está empenhada em criar ondas. Eles já levantaram US$ 640 milhões em capital de risco e estão focados na construção de modelos de IA que não apenas rivalizam com empresas como GPT-4 da OpenAI e Claude da Anthropic, mas também obtêm lucro no processo.

E embora ganhar dinheiro no espaço generativo de IA seja tão fácil quanto ganhar na loteria, Mistral não recua. Na verdade, eles começaram a gerar receita no verão passado, o que é mais do que você pode dizer de muitos de seus concorrentes.

Ao oferecer o Ministral 8B para fins de investigação e disponibilizar ambos os modelos através da sua plataforma de nuvem, La Platforme, a Mistral está a posicionar-se como o garoto fixe no bloco da IA – suficientemente aberto para atrair programadores, mas suficientemente inteligente para rentabilizar a sua tecnologia através de parcerias estratégicas. É uma abordagem híbrida que reflete o que gigantes do código aberto como a Red Hat fizeram no mundo Linux, promovendo a comunidade enquanto mantinham as caixas registradoras funcionando.

Créditos da imagem: Mistral