Colossus é um sistema inovador de treinamento de inteligência artificial (IA) desenvolvido por Elon Musk xAI Corporação. Este supercomputador, descrito por Musk como o “sistema de treinamento de IA mais poderoso do mundo”, é um componente crítico da estratégia da xAI para liderar no campo de rápida evolução da IA.

Este fim de semana, o @xAI equipe colocou nosso cluster de treinamento Colossus 100k H100 online. Do início ao fim, foi feito em 122 dias.

Colossus é o sistema de treinamento de IA mais poderoso do mundo. Além disso, ele dobrará de tamanho para 200k (50k H200s) em alguns meses.

Excelente…

— Elon Musk (@elonmusk) 2 de setembro de 2024

A Nvidia irá equipar o Colossus

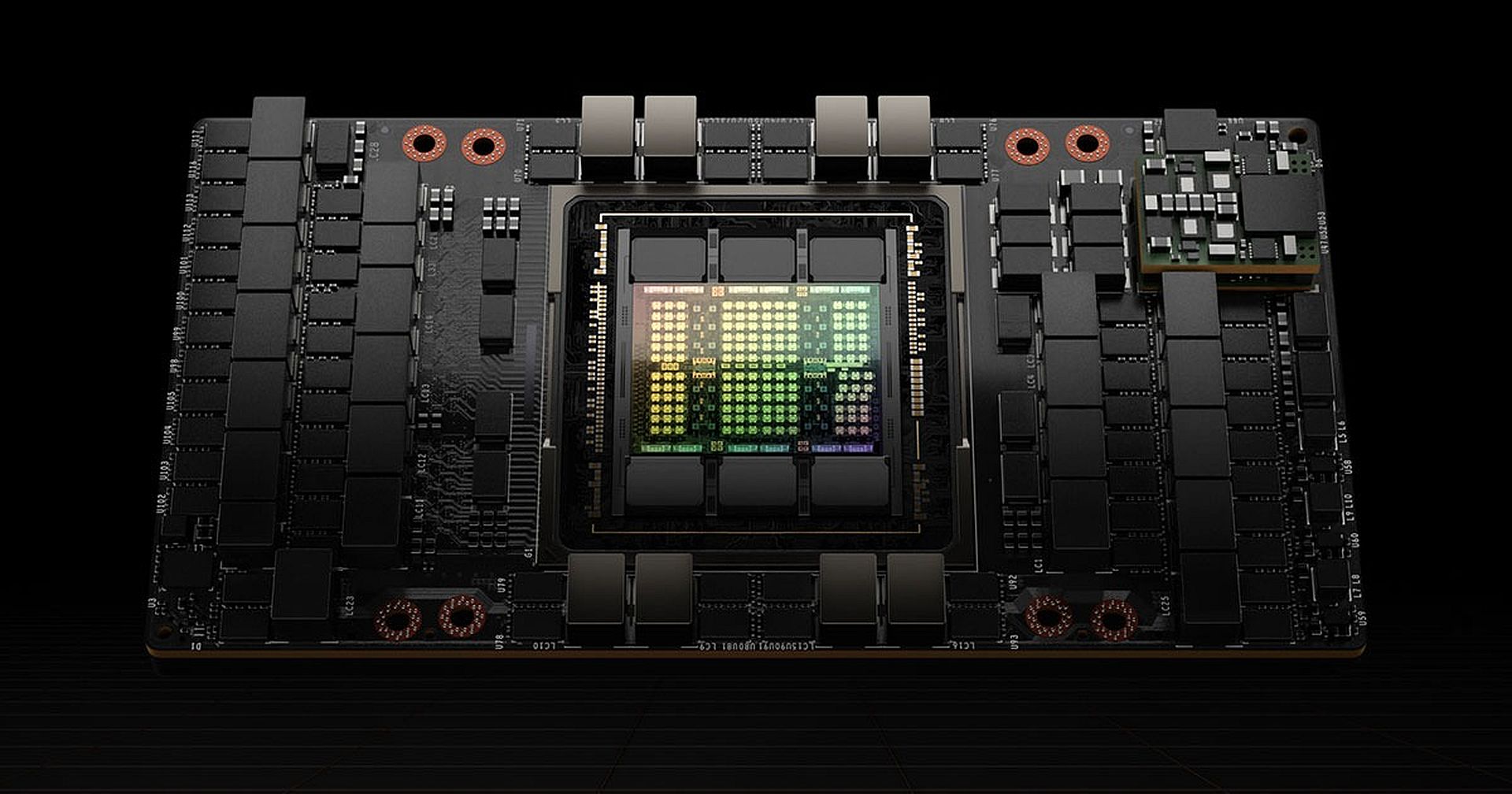

No centro do Colossus estão 100.000 Placas gráficas NVIDIA H100. Essas GPUs (Unidades de Processamento Gráfico) são projetadas especificamente para lidar com os exigentes requisitos computacionais do treinamento de IA e aqui está o motivo pelo qual essas GPUs são tão vitais:

- Poder de processamento bruto: O H100 é o principal processador de IA da Nvidia, projetado para acelerar o treinamento e a inferência de modelos de IA, particularmente aqueles baseados em aprendizado profundo e redes neurais. Comparado ao seu antecessor, o H100 pode executar modelos de linguagem de até 30 vezes mais rápido.

- Motor transformador: Uma característica fundamental do H100 é seu Transformer Engine, um conjunto especializado de circuitos otimizados para executar modelos de IA com base na arquitetura de rede neural Transformer. Essa arquitetura é a espinha dorsal de alguns dos modelos de linguagem mais avançados, como GPT-4 e Lhama de Meta 3.1 405B. O Transformer Engine permite que essas GPUs manipulem modelos em larga escala com mais eficiência, tornando-as ideais para treinar sistemas de IA sofisticados.

O próximo nível: Dobrando com o H200

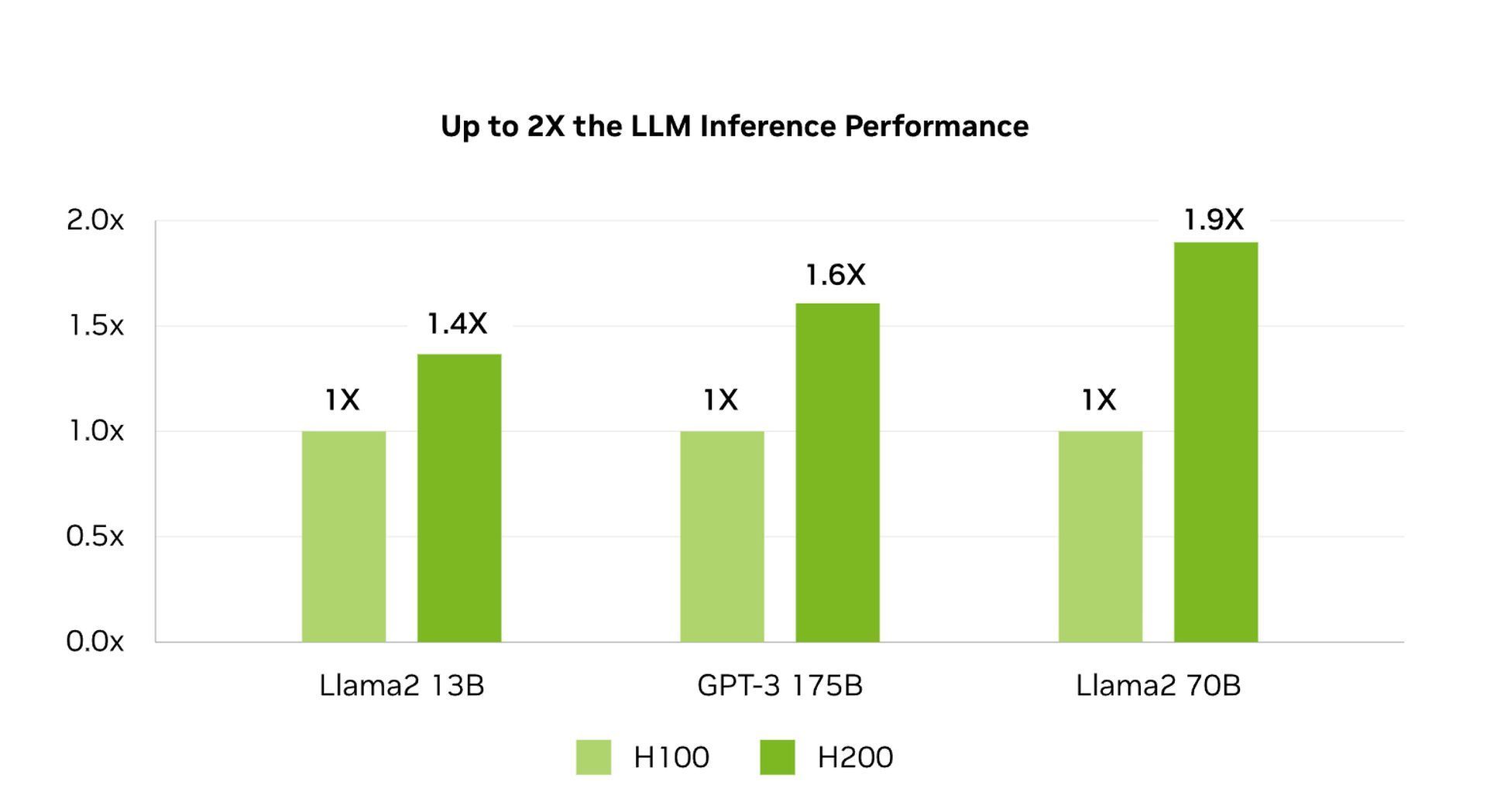

Musk tem planos ambiciosos para expandir ainda mais o Colossus, com o objetivo de dobrar a contagem de GPU do sistema para 200.000 num futuro próximo. Esta expansão incluirá 50.000 unidades de H200 da Nvidiaum sucessor ainda mais poderoso do H100. O H200 oferece várias atualizações significativas:

- Memória HBM3e: O H200 usa High Bandwidth Memory 3e (HBM3e), que é mais rápido do que o HBM3 usado no H100. Esse tipo de memória aumenta a velocidade na qual os dados são transferidos entre a memória e os circuitos lógicos do chip. Para modelos de IA, que constantemente embaralham grandes quantidades de dados entre o processamento e a memória, essa velocidade é crucial.

- Capacidade de memória aumentada:O H200 quase dobra a capacidade de memória interna para 141 gigabytes. Isso permite que a GPU armazene mais dados de um modelo de IA mais perto de seus circuitos lógicos, reduzindo a necessidade de buscar dados de fontes de armazenamento mais lentas. O resultado são tempos de processamento mais rápidos e treinamento de modelo mais eficiente.

O papel do Colossus no treinamento de IA

O Colossus foi projetado especificamente para treinar grandes modelos de linguagem (LLMs)que são a base de aplicações avançadas de IA.

O grande número de GPUs no Colossus permite que o xAI treine modelos de IA em uma escala e velocidade inigualáveis por outros sistemas. Por exemplo, o atual carro-chefe do xAI, LLM, Grok-2, foi treinado em 15.000 GPUs. Com 100.000 GPUs agora disponíveis, o xAI pode treinar modelos muito maiores e mais complexos, potencialmente levando a melhorias significativas nas capacidades de IA.

A arquitetura avançada das GPUs H100 e H200 garante que os modelos sejam treinados não apenas mais rápido, mas com maior precisão. A alta capacidade de memória e as capacidades de transferência rápida de dados significam que mesmo os modelos de IA mais complexos podem ser treinados de forma mais eficiente, resultando em melhor desempenho e precisão.

O que vem depois?

Colossus não é apenas uma conquista técnica; é um ativo estratégico na missão da xAI de dominar a indústria de IA. Ao construir o sistema de treinamento de IA mais poderoso do mundo, a xAI se posiciona como líder no desenvolvimento de modelos de IA de ponta. Este sistema dá à xAI uma vantagem competitiva sobre outras empresas de IA, incluindo a OpenAI, na qual Musk está atualmente conflito legal com.

Além disso, a construção do Colossus reflete a visão mais ampla de Musk para a IA. Ao realocar recursos da Tesla para a xAI, incluindo o redirecionamento de 12.000 GPUs H100 no valor de mais de US$ 500 milhões, Musk demonstra seu comprometimento com a IA como foco central de seu império empresarial.

Ele pode ter sucesso? Temos que esperar pela resposta!

Crédito da imagem em destaque: Eray Eliaçık/Grok