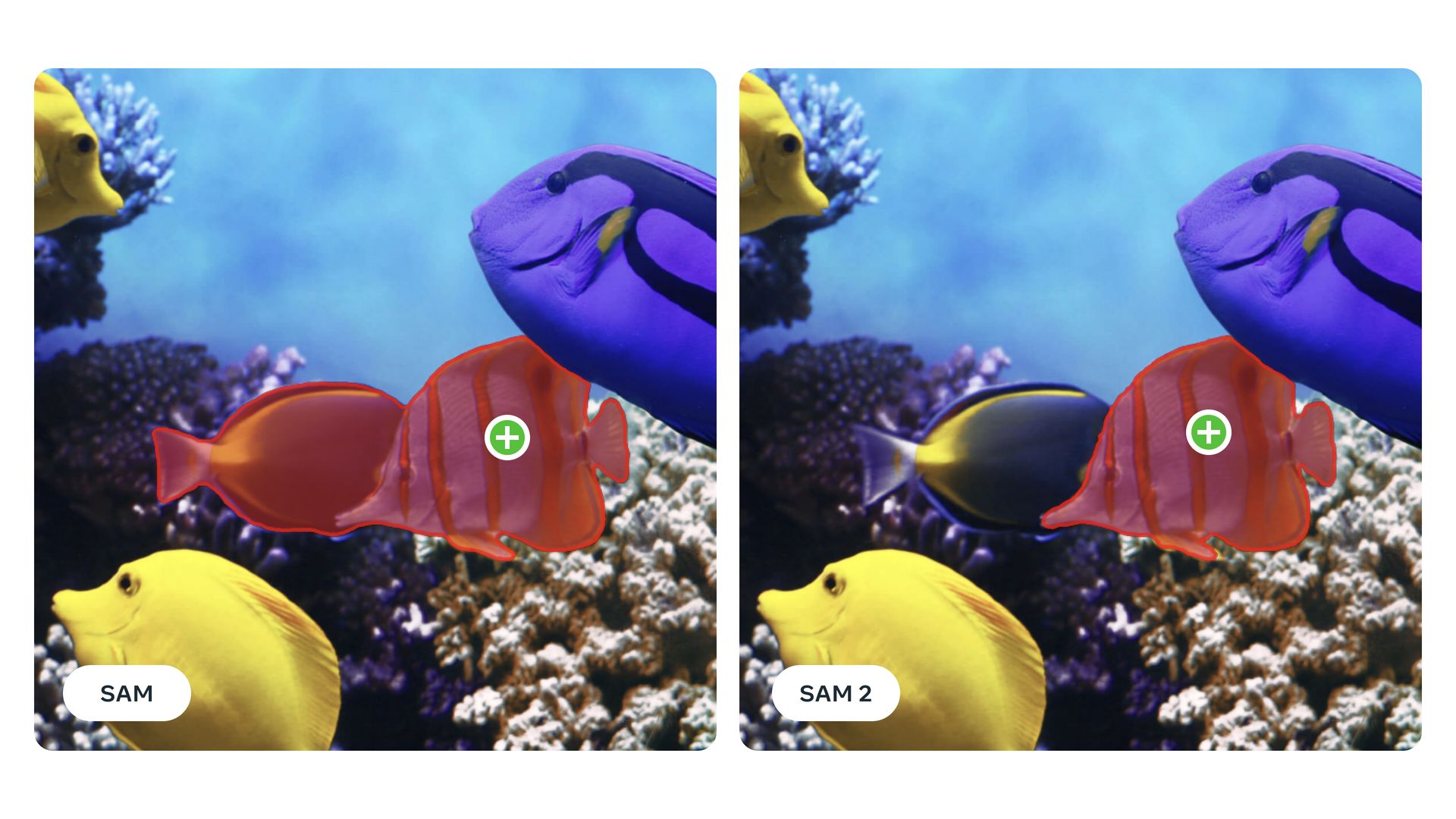

O Meta Segment Anything Model 2 (SAM 2) está fazendo sucesso com suas capacidades impressionantes. Ao contrário dos modelos tradicionais que lutam com novos tipos de objetos, o SAM 2 usa aprendizado zero-shot para identificar e segmentar itens nos quais não foi treinado especificamente. Isso significa que ele pode lidar facilmente com uma ampla variedade de conteúdo visual.

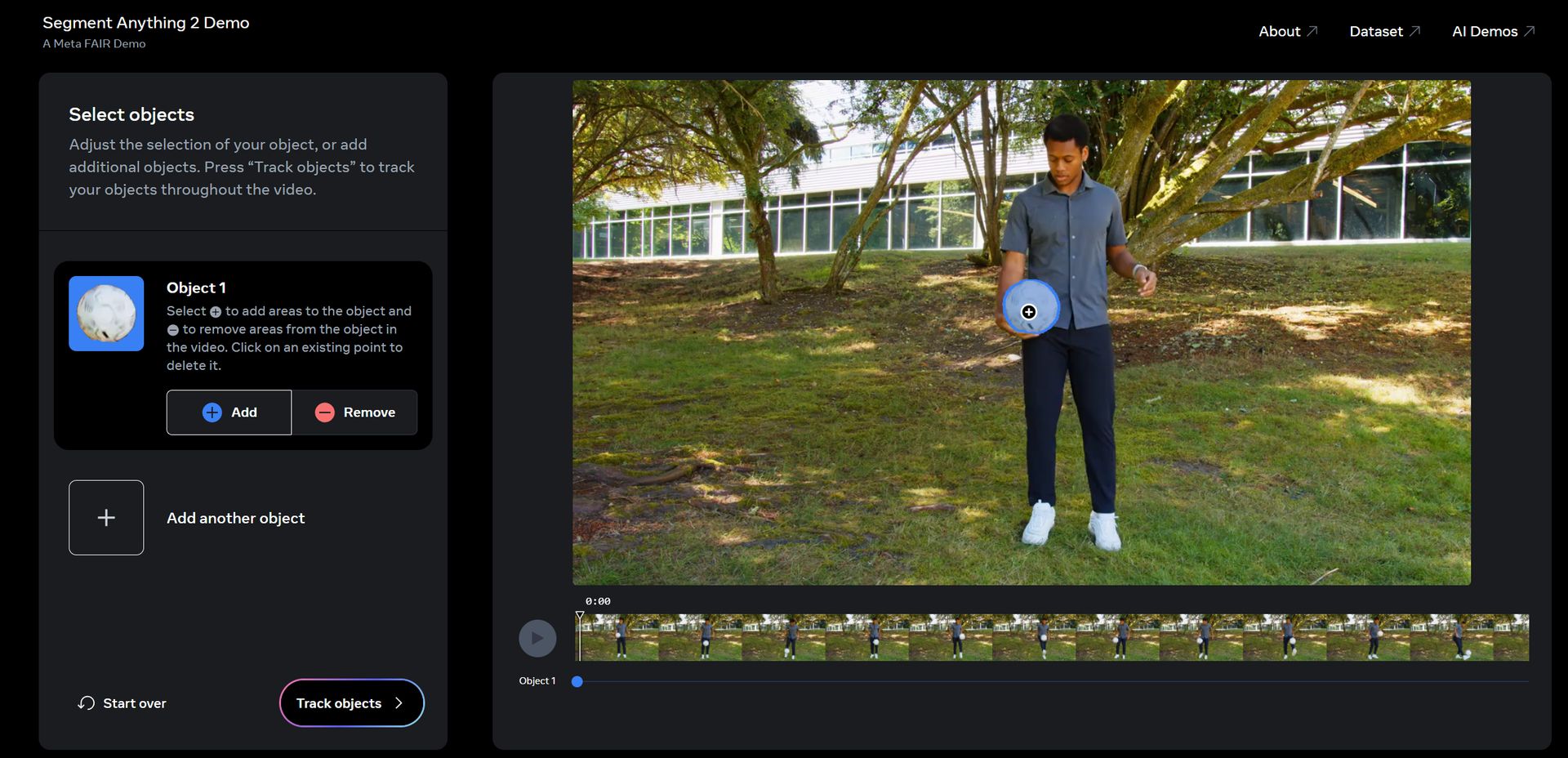

Imagine uma ferramenta que não apenas segmenta objetos em um único quadro, mas rastreia e mantém a continuidade do objeto em uma sequência de vídeo inteira, mesmo em meio a oclusões e mudanças rápidas. O SAM 2 consegue isso por meio de sua arquitetura unificada e mecanismo de memória. Veja como.

Meta Segment Anything Model 2 (SAM 2) explicado

O Meta Segment Anything Model 2 é um modelo avançado de visão computacional projetado para lidar com segmentação de objetos em uma variedade de tipos de mídia, incluindo imagens e vídeos. Ao contrário dos modelos de segmentação tradicionais que podem exigir um extenso retreinamento para novos tipos de objetos, o SAM 2 é equipado com recursos de aprendizado zero-shot. Graças às suas robustas habilidades de generalização, isso significa que ele pode segmentar objetos nos quais não foi explicitamente treinado. Isso é particularmente útil para aplicativos com conteúdo visual diverso ou em evolução, onde novas categorias de objetos surgem com frequência.

O núcleo da funcionalidade do Meta SAM 2 é sua arquitetura unificada, que processa imagens e quadros de vídeo. Essa arquitetura incorpora um mecanismo de memória que ajuda a manter a continuidade entre quadros de vídeo, abordando desafios como oclusão e movimento de objetos.

O codificador de memória do modelo captura informações de quadros anteriores, que são armazenadas em um banco de memória e acessadas por um módulo de atenção de memória. Essa configuração garante que o modelo possa rastrear e segmentar objetos com precisão ao longo do tempo, mesmo quando eles estão parcialmente obscurecidos ou quando a cena muda dinamicamente.

O SAM 2 também é altamente interativo, permitindo que os usuários forneçam vários tipos de prompts — como cliques, caixas delimitadoras ou máscaras — para orientar o processo de segmentação. Esse recurso de segmentação promptável permite que os usuários refinem os resultados da segmentação com base em suas necessidades específicas e abordem quaisquer ambiguidades na detecção de objetos. Ao encontrar cenas complexas onde múltiplas interpretações são possíveis, o SAM 2 pode gerar várias máscaras potenciais e selecionar a mais apropriada com base em níveis de confiança.

O modelo é treinado e avaliado usando o Conjunto de dados SA-Vque é notável por sua escala e diversidade. Este conjunto de dados inclui cerca de 51.000 sequências de vídeo do mundo real e mais de 600.000 masklets, fornecendo um recurso abrangente para treinamento e teste de modelos de segmentação. As anotações neste conjunto de dados são geradas interativamente com o próprio SAM 2, garantindo alta precisão e relevância para cenários do mundo real. O conjunto de dados cobre uma ampla gama de localizações geográficas e vários tipos de conteúdo visual, incluindo cenários com visualizações parciais de objetos e oclusões.

O Segment Anything Model (SAM) 2 da Meta representa um grande avanço na segmentação de vídeo interativa, superando drasticamente os modelos anteriores. Ele se destaca em 17 conjuntos de dados de vídeo zero-shot, exigindo três vezes menos interações humanas e entregando resultados seis vezes mais rápido do que seu antecessor, SÃO. O SAM 2 supera benchmarks existentes como DAVIS e YouTube-VOS e processa vídeo a aproximadamente 44 quadros por segundo, tornando-o altamente eficiente para aplicações em tempo real. Sua capacidade de executar segmentação de vídeo 8,4 vezes mais rápido do que a anotação manual com SAM ressalta ainda mais sua eficácia e eficiência no manuseio de tarefas complexas de vídeo.

Os avanços do SAM 2 não são apenas significativos para aplicações práticas, como análise e anotação de vídeo, mas também contribuem para o campo mais amplo da pesquisa de visão computacional. Ao tornar seu código e conjunto de dados publicamente disponíveis, a Meta incentiva mais inovação e desenvolvimento em tecnologia de segmentação. Melhorias futuras podem se concentrar em aprimorar a capacidade do modelo de lidar com oclusões de longo prazo e cenas cada vez mais complexas com vários objetos em movimento, continuando a expandir os limites do que é possível na segmentação de objetos.

Como usar o SAM 2

O Meta Segment Anything Model 2 (SAM 2) tem uma demonstração na web, você só precisa:

- Clique aqui e visite a página de demonstração.

- Aceite o aviso

- Clique em um ou mais objetos que você deseja seguir.

- Clique em “Rastrear objetos”

- Controle a saída. Se não houver problemas, clique em “Next”

- Adicione efeitos como quiser ou deixe a IA fazer o seu trabalho clicando em “Surpreenda-me”

- Clique em “Avançar”

- Agora, você pode obter um link para ele ou baixá-lo. Aqui está nosso resultado:

Teste Meta Segment Anything Model 2 (SAM 2) foto.twitter.com/d07PGto0eO

-Alan Davis (@AlanDav73775659) 30 de julho de 2024

Isso é tudo!

Crédito da imagem em destaque: Meta