A corrida por modelos de inteligência artificial cada vez maiores tem sido uma marca registrada dos avanços recentes. No entanto, a Microsoft está agitando as coisas com o Phi-3 Mini, um modelo de IA que apresenta capacidades impressionantes apesar do seu tamanho compacto.

Tradicionalmente, o sucesso em grandes modelos de linguagem (LLMs) tem sido associado ao número de parâmetros – essencialmente os blocos de construção que informam a compreensão da linguagem pelo modelo.

Levando em consideração os custos de computação e a disponibilidade para todos, o Microsoft Phi-3 está aqui para mudar essa abordagem “tradicional”.

O Microsoft Phi-3 Mini cabe um gigante no seu bolso

GPT-3.5, atual líder na corrida LLM, possui impressionantes 175 bilhões de parâmetros. Este imenso número permite que o GPT-3.5 processe grandes quantidades de dados de texto, proporcionando uma compreensão ampla e diferenciada da linguagem. No entanto, esta complexidade também tem um custo. A execução de um modelo com uma contagem de parâmetros tão alta requer recursos computacionais significativos, o que o torna caro e consome muita energia.

O minimodelo da Microsoft, por outro lado, adota uma abordagem diferente. Ao utilizar um conjunto muito menor de parâmetros – apenas 3,8 bilhões – o Phi-3 Mini opera com um nível de eficiência que supera seus equivalentes maiores. Esta redução de tamanho traduz-se em diversas vantagens.

Tudo isso torna o Microsoft Phi-3:

- Significativamente mais barato para operar

- Uma potência potencial para aplicativos de IA no dispositivo

Regime de treinamento do Phi-3 Mini

Outro aspecto intrigante do Phi-3 Mini é o seu método de treinamento.

Ao contrário de seus equivalentes maiores, treinados em enormes conjuntos de dados de texto e código, a educação do Phi-3 Mini envolveu uma seleção mais cuidadosa. Os investigadores optaram por um currículo inspirado na forma como as crianças aprendem – utilizando livros infantis como base.

Esta abordagem parece ter produzido resultados positivos, com o Phi-3 Mini demonstrando desempenho rivalizando com o do GPT-3.5 em vários benchmarks.

Comparado para o sucesso

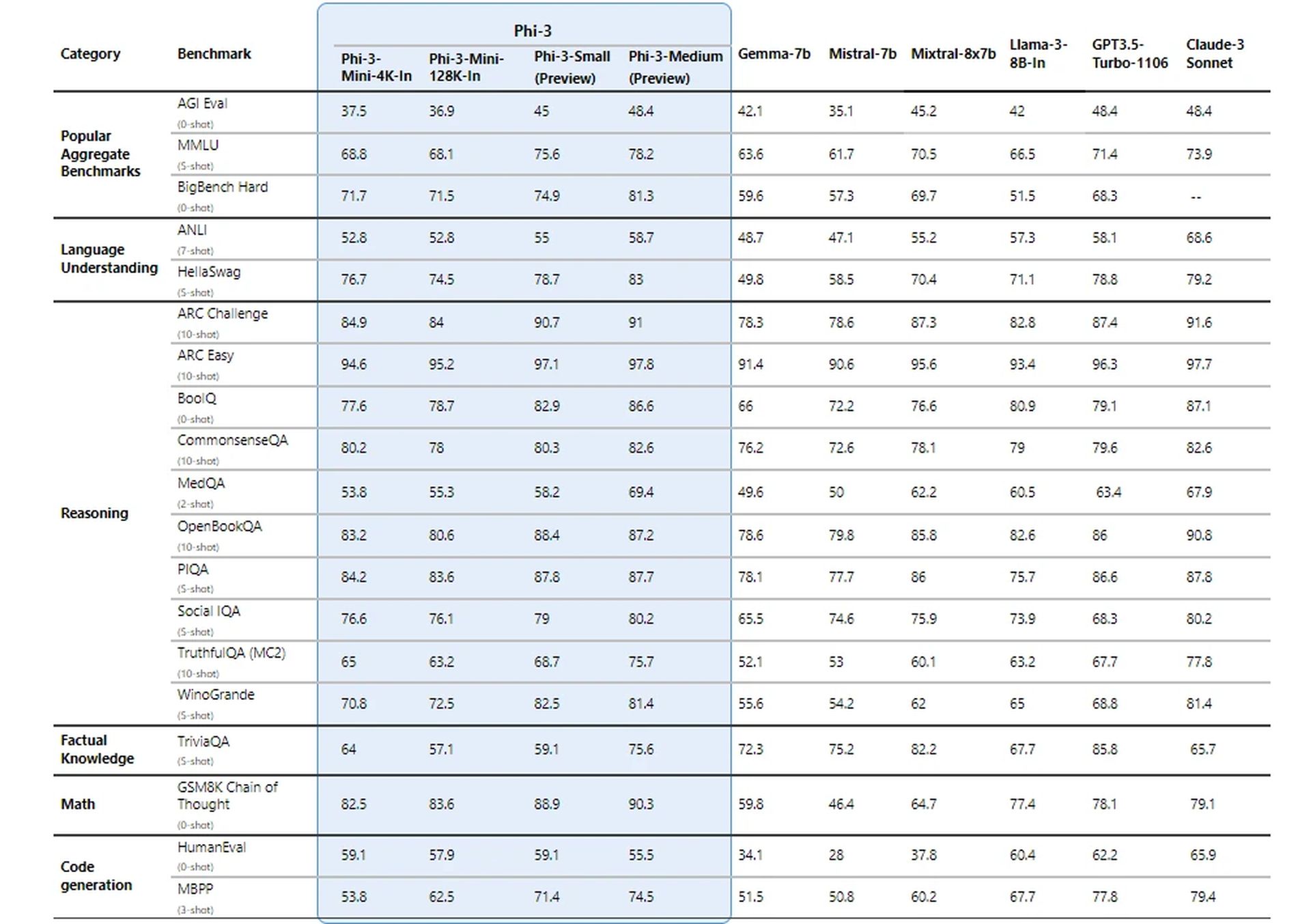

Os pesquisadores da Microsoft testaram seu novo modelo usando benchmarks estabelecidos para LLMs. O modelo obteve pontuações impressionantes em métricas como MMLU (uma medida da capacidade de um modelo de compreender relações complexas na linguagem) e MT-bench (um teste para capacidades de tradução automática).

Esses resultados sugerem que o Phi-3 Mini, apesar de seu tamanho, pode competir com os grandes nomes do jogo LLM.

Como consegue resultados tão impressionantes?

Os detalhes técnicos do Phi-3 Mini revelam uma abordagem fascinante para alcançar resultados impressionantes com um modelo notavelmente pequeno. Aqui está uma análise dos principais aspectos:

Arquitetura do decodificador do transformador

Phi-3 Mini utiliza uma arquitetura de decodificador de transformador, uma escolha de design predominante para modelos de linguagem eficazes. Essa arquitetura é excelente no processamento de dados sequenciais como texto, permitindo ao modelo compreender as relações entre as palavras em uma frase.

Comprimento do contexto

O Phi-3 Mini padrão opera com um comprimento de contexto de 4.000 tokens. Define o número máximo de tokens (palavras ou partes de palavras) que o modelo considera ao gerar o texto. Um comprimento de contexto mais longo permite uma compreensão mais profunda da conversa anterior, mas também requer mais poder de processamento.

Versão de contexto longo (Phi-3-Mini-128K)

Para tarefas que exigem um contexto mais amplo, está disponível uma variante chamada Phi-3-Mini-128K. Esta versão estende o comprimento do contexto para impressionantes 128.000 tokens, permitindo lidar com sequências de informações mais complexas.

Compatibilidade com ferramentas existentes

Para beneficiar a comunidade de desenvolvedores, o Phi-3 Mini compartilha uma estrutura e tamanho de vocabulário semelhantes (320.641) com a família de modelos Llama-2. Essa compatibilidade permite que os desenvolvedores aproveitem as ferramentas e bibliotecas existentes projetadas para o Llama-2 ao trabalhar com o Phi-3 Mini.

Parâmetros do modelo

É aqui que o Phi-3 Mini realmente brilha. Com apenas 3,072 bilhões de parâmetros, ele opera muito abaixo dos números surpreendentes vistos em modelos maiores como o GPT-3.5 (175 bilhões de parâmetros).

Esta redução significativa nos parâmetros traduz-se numa eficiência excepcional em termos de poder de processamento e utilização de memória.

Saif Naik da Microsoft explica:

“Nosso objetivo com o copiloto Krishi Mitra é melhorar a eficiência e, ao mesmo tempo, manter a precisão de um grande modelo de linguagem. Estamos entusiasmados com a parceria com a Microsoft no uso de versões aprimoradas do Phi-3 para atingir nossos objetivos: eficiência e precisão!”

– Saif Naik, Chefe de Tecnologia, ITCMAARS

Metodologia de treinamento

O treinamento do Phi-3 Mini se inspira na abordagem “Os livros didáticos são tudo que você precisa”. Este método enfatiza dados de treinamento de alta qualidade em vez de simplesmente aumentar o tamanho do modelo. Os dados de treinamento são cuidadosamente selecionados, com foco em fontes da web com um “nível educacional” específico e em dados sintéticos gerados por outros LLMs.

Esta estratégia permite que o Phi-3 Mini alcance resultados impressionantes apesar do seu tamanho compacto.

Filtragem de dados para aprendizagem ideal

Ao contrário das abordagens tradicionais que priorizam recursos computacionais ou treinamento excessivo, o Phi-3 Mini se concentra em um “regime ideal de dados” para seu tamanho. Isso envolve filtrar meticulosamente os dados da web para garantir que contenham o nível certo de “conhecimento” e promovam habilidades de raciocínio.

Por exemplo, dados desportivos gerais podem ser excluídos para dar prioridade a informações que melhorem a capacidade de raciocínio do modelo.

Ajuste fino pós-treinamento

Após o processo de treinamento básico, o novo modelo passa por refinamento adicional por meio de ajuste fino supervisionado (SFT) e otimização de preferência direta (DPO). SFT expõe o modelo a dados selecionados em vários domínios, incluindo matemática, codificação e princípios de segurança. O DPO ajuda a desviar o modelo de comportamentos indesejados, identificando e excluindo resultados indesejáveis.

Esta fase pós-treinamento transforma o Phi-3 Mini de um modelo de linguagem em um assistente de IA versátil e seguro.

Desempenho eficiente no dispositivo

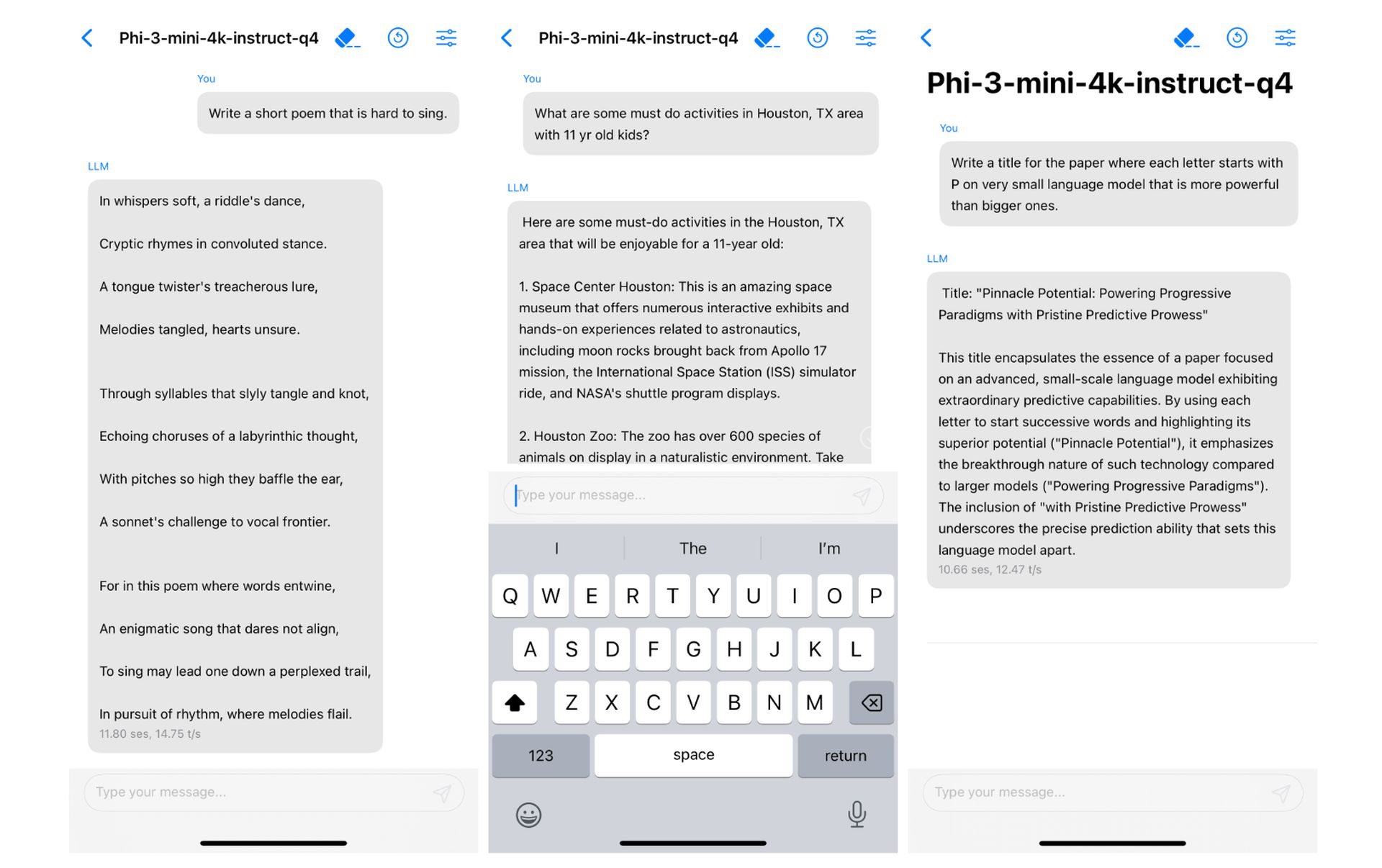

O tamanho pequeno do Phi-3 Mini se traduz em desempenho excepcional no dispositivo. Ao quantizar o modelo em 4 bits, ele ocupa apenas 1,8 gigabytes de memória.

Um casamento feito no céu

Você se lembra das tentativas fracassadas da Microsoft com smartphones? A respeito Acordos fracassados de integração do Google Gemini da Apple nos últimos meses? Ou você está acompanhando as notícias da Apple falando sobre a integração de um LLM no dispositivo com iOS 18 nas últimas semanas?

Isso toca uma campainha?

As aplicações potenciais do Phi-3 Mini são vastas. Sua eficiência o torna ideal para integração em dispositivos móveis, possibilitando recursos como assistentes virtuais mais inteligentes e tradução de idiomas em tempo real. Além disso, a sua relação custo-eficácia poderia abrir portas para uma adoção mais ampla por parte dos desenvolvedores que trabalham em vários projetos alimentados por IA.

E era exatamente isso que a Apple procurava. É claro que esta afirmação nada mais é do que um palpite por enquanto, mas não seria errado dizer que se trata de uma “combinação feita no céu”. Além disso, no artigo de pesquisa, o novo projeto da Microsoft já foi executado em um iPhone com chip A16 Bionic nativamente.

O sucesso do Phi-3 Mini depende de uma combinação de fatores – uma arquitetura adequada, uso eficiente do comprimento do contexto, compatibilidade com ferramentas existentes, foco em dados de treinamento de alta qualidade e técnicas de otimização. Esta abordagem única abre caminho para modelos de IA poderosos e eficientes que podem operar perfeitamente em dispositivos pessoais.

Crédito da imagem em destaque: vecstock/Freepik