meta feito seu novo código aberto Llama 3 LLM e você pode executá-lo localmente com Ollama. Ao tornar o Llama 3 de código aberto, a Meta liberou um grande potencial para empresas de todos os tamanhos. Isso significa que o código subjacente do Llama 3 está disponível gratuitamente para exame, adaptação e utilização por qualquer parte interessada. As implicações para a comunidade empresarial, especialmente para as pequenas e médias empresas, são substanciais.

Através de uma estrutura de licenciamento permissiva, as PME podem aproveitar o poder do Llama 3 para os seus projetos específicos sem encontrar restrições pesadas. Desde que seja mantida a adesão às normas legais estabelecidas, as PME têm a liberdade de explorar o extenso potencial desta tecnologia de ponta.

O que é Lhama 3?

Llama 3 é um LLM desenvolvido pela Meta, a empresa afirma que é “o LLM mais capaz disponível abertamente até o momento”.

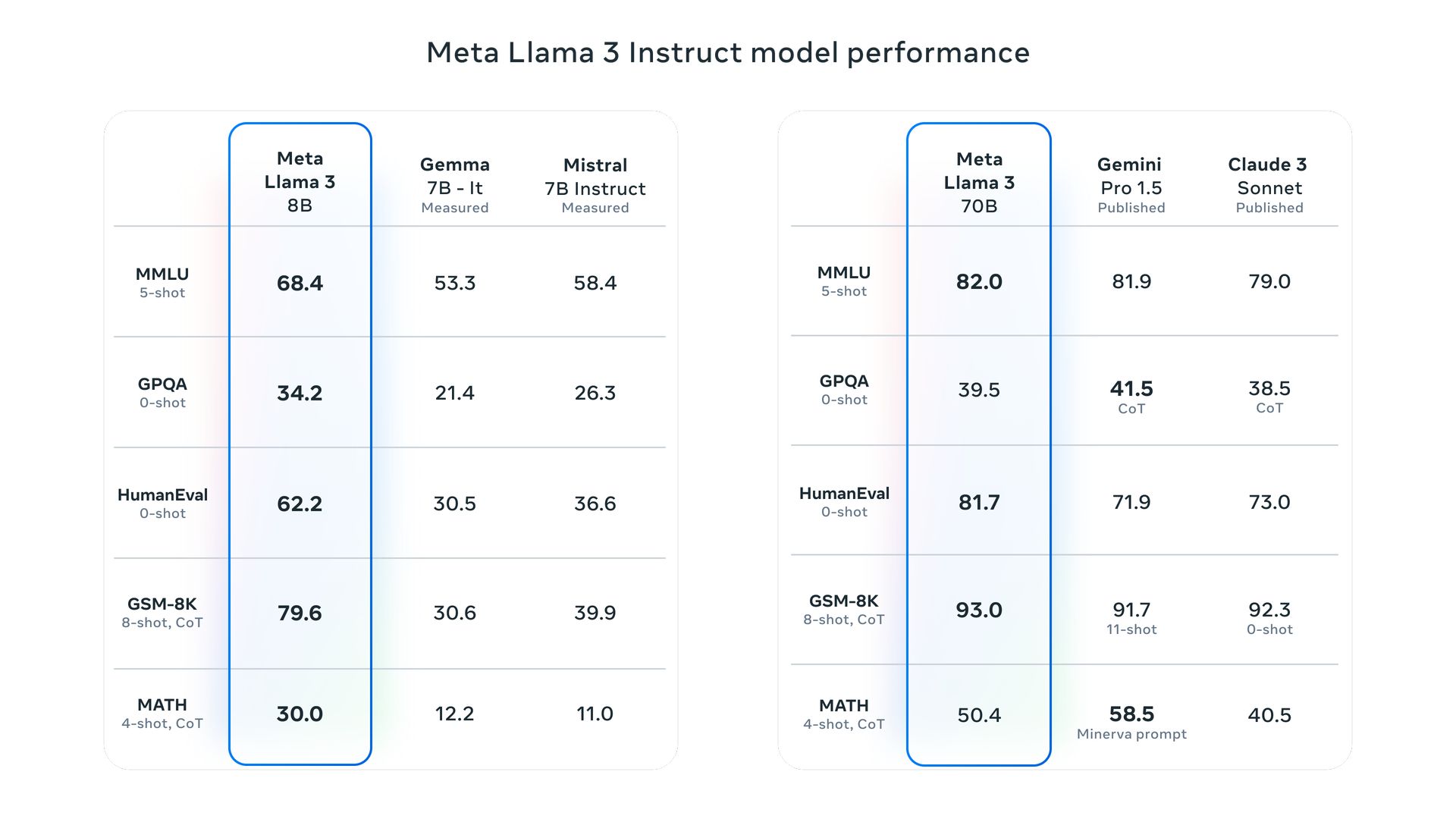

O Llama 3 vem em dois tamanhos: 8 bilhões e 70 bilhões de parâmetros. Esse tipo de modelo é treinado em uma grande quantidade de dados de texto e pode ser usado para uma variedade de tarefas, incluindo geração de texto, tradução de idiomas, escrita de diferentes tipos de conteúdo criativo e resposta às suas perguntas de forma informativa. Meta considera o Llama 3 um dos melhores modelos abertos disponíveis, mas ainda está em desenvolvimento.

“Com o Llama 3, pretendemos construir os melhores modelos abertos que estejam no mesmo nível dos melhores modelos proprietários disponíveis hoje”, diz a postagem do blog da Meta.

Os modelos Llama 3 utilizam dados para alcançar um dimensionamento sem precedentes. Eles foram treinados usando dois clusters de GPU de 24K personalizados recém-revelados em mais de 15 trilhões de tokens de dados. Este conjunto de dados de treinamento é sete vezes maior que o usado para o Llama 2 e inclui quatro vezes mais código, melhorando significativamente suas capacidades e amplitude de conhecimento.

Nós discutimos Referências do Lhama 3 mostrando como o modelo teve um desempenho excepcional em todas as tarefas avaliadas.

Como o Meta Llama 3 melhora em relação às versões anteriores?

Os modelos Meta Llama 3 passaram por melhorias significativas nos processos de pré-treinamento e ajuste fino, o que aumenta sua capacidade de se alinhar melhor às instruções do usuário, gerar respostas mais diversas e reduzir as taxas de erro. As principais melhorias tecnológicas incluem um tokenizer mais eficiente e Group Query Attention (GQA), melhorando a eficiência da inferência.

O Llama 3 é multimodal?

Atualmente, o Llama 3 opera com dados textuais e visuais para determinadas aplicações, mas o Meta pretende aprimorar suas capacidades de processamento de imagens. Até o final de 2024, eles planejam lançar o Llama 4, projetado para se destacar na interpretação e geração de imagens complexas com base em descrições textuais.

Este avanço permitirá modificações sofisticadas de imagens, melhorias na representação de cenas e a criação de imagens realistas em vários estilos, mesclando as capacidades de compreensão da linguagem e percepção visual para resultados mais impressionantes.

Como acessar o Lhama 3?

Atualmente, o acesso ao Llama 3 é possível localmente através do Ollama, o que facilita a implantação e operação de grandes modelos de linguagem.

O que Ollama faz?

Ollama fornece uma plataforma para executar grandes modelos de linguagem de código aberto, como o Llama 2, em sistemas locais. Ele integra pesos de modelo, configuração e dados necessários em um pacote unificado especificado por um Modelfile e simplifica o processo de configuração, incluindo a otimização do uso da GPU para desempenho aprimorado.

O Ollama está disponível no Windows?

Em relação à compatibilidade, Ollama agora está acessível no Windows em versão prévia. Esta versão permite que os usuários gerenciem grandes modelos de linguagem diretamente no Windows, com aceleração de GPU, acesso completo à biblioteca de modelos e uma API Ollama que oferece suporte a protocolos OpenAI.

Como funciona o Ollama?

Ollama emprega uma arquitetura transformadora, um tipo de modelo de aprendizagem profunda que é fundamental em grandes modelos de linguagem. Ao analisar extensos dados de texto, Ollama domina as nuances da linguagem, permitindo-lhe compreender o contexto das consultas, produzir respostas sintaticamente corretas e contextualmente significativas e realizar uma tradução precisa do idioma, capturando a essência do idioma de origem e transmitindo-a de forma eficaz no idioma de destino. linguagem.

O Llama 3 será de código aberto?

Em termos de disponibilidade, Meta declarou que o Llama 3 é de código aberto, promovendo acessibilidade e inovação mais amplas na comunidade tecnológica.

Posso executar o Llama 3 localmente?

Sim, o Ollama facilita a execução de vários modelos de linguagem grandes, incluindo o Llama 3, em computadores pessoais. Ele aproveita a eficiência do llama.cpp, uma biblioteca de código aberto que permite a operação local de LLMs mesmo em sistemas com especificações de hardware modestas. Além disso, Ollama incorpora uma espécie de gerenciador de pacotes, que simplifica o processo de download e utilização de LLMs por meio de um único comando, aumentando a velocidade e a facilidade de uso.

Quais recursos de segurança estão integrados ao Meta Llama 3?

Meta integrou vários recursos de segurança no Llama 3, como Llama Guard 2 e Cybersec Eval 2, para lidar com questões de segurança. Essas ferramentas ajudam a filtrar resultados problemáticos e a garantir uma implantação segura. Além disso, os modelos foram submetidos a red-teaming para testar e refinar a sua resposta às entradas adversárias.

Quais são os objetivos futuros do Meta Llama 3?

A Meta planeja estender o Llama 3 para oferecer suporte a recursos multilíngues e multimodais, lidar com comprimentos de contexto mais longos e melhorar ainda mais o desempenho em todos os recursos principais dos modelos de linguagem. O objetivo é também manter os modelos abertos ao envolvimento da comunidade e melhorias iterativas.

Crédito da imagem em destaque: meta