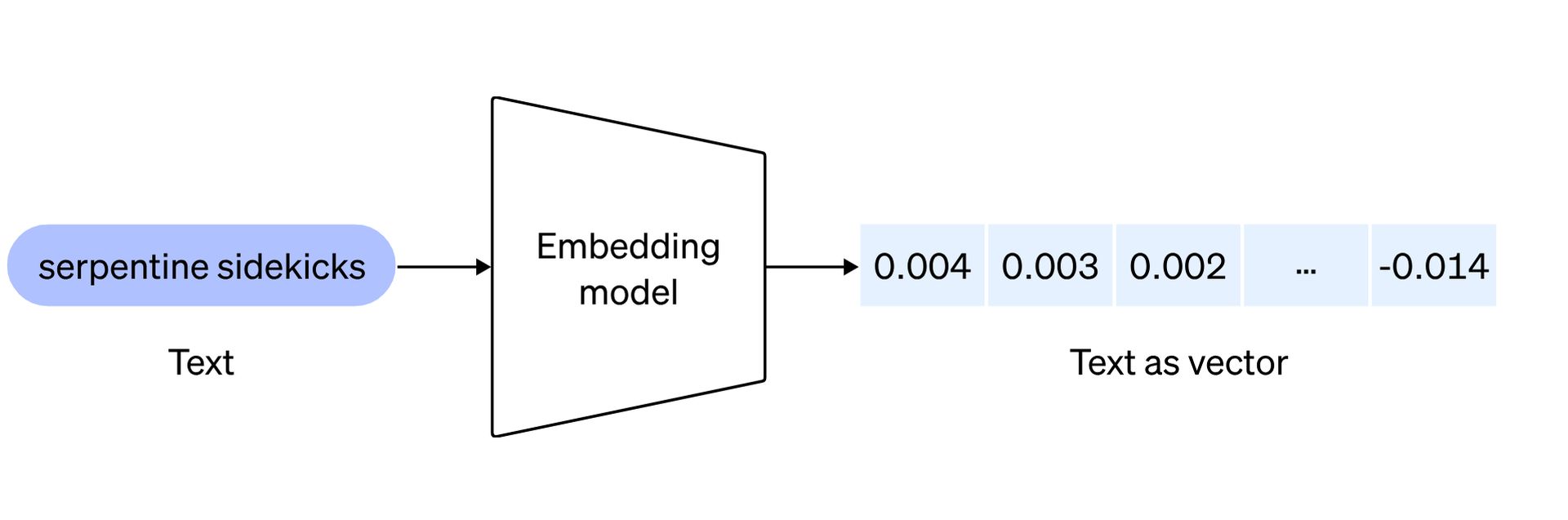

O reino da inteligência artificial continua a evoluir com os novos modelos de incorporação OpenAI. Eles foram criados para redefinir a forma como os desenvolvedores abordam o processamento de linguagem natural. Antes de explorar os dois modelos inovadores, cada um projetado para elevar as capacidades das aplicações de IA, aqui está o que incorporações significar:

Os embeddings de texto da OpenAI servem como uma métrica para avaliar a correlação entre sequências de texto, encontrando aplicações em vários domínios, incluindo:

- Procurar: utilizado para classificar resultados com base em sua relevância para uma determinada string de consulta, aumentando a precisão dos resultados da pesquisa.

- Agrupamento: Empregado para agrupar sequências de texto com base em suas semelhanças, facilitando a organização de informações relacionadas.

- Recomendações: aplicado em sistemas de recomendação para sugerir itens que tenham pontos em comum em suas sequências de texto, potencializando a personalização das sugestões.

- Detecção de anomalia: Empregado para identificar valores discrepantes com relação mínima, auxiliando na detecção de padrões ou pontos de dados irregulares.

- Medição da diversidade: Utilizado para analisar distribuições de similaridade, permitindo a avaliação da diversidade em conjuntos de dados ou corpora de texto.

- Classificação: implantado em tarefas de classificação em que sequências de texto são categorizadas de acordo com seu rótulo mais semelhante, simplificando o processo de rotulagem em aplicativos de aprendizado de máquina.

Agora você está pronto para explorar os novos modelos de incorporação OpenAI!

Chegaram novos modelos de incorporação OpenAI

A introdução dos novos modelos de incorporação OpenAI marca um salto significativo no processamento de linguagem natural, permitindo aos desenvolvedores representar e compreender melhor o conteúdo textual. Vamos nos aprofundar nos detalhes desses modelos inovadores: incorporação de texto-3-pequeno e incorporação de texto-3-grande.

incorporação de texto-3-pequeno

Este modelo compacto, mas poderoso, exibe um notável aumento de desempenho em relação ao seu antecessor, text-embedding-ada-002. No benchmark de recuperação multilíngue (MIRACL), a pontuação média disparou de 31,4% para impressionantes 44,0%. Da mesma forma, no benchmark de tarefas de inglês (MTEB), a pontuação média teve um aumento louvável de 61,0% para 62,3%. No entanto, o que diferencia o text-embedding-3-small não é apenas seu desempenho aprimorado, mas também sua acessibilidade.

| Referência de avaliação | ada v2 | incorporação de texto-3-pequeno | incorporação de texto-3-grande |

| Média MIRACL | 31.4 | 44,0 | 54,9 |

| Média MTEB | 61,0 | 62,3 | 64,6 |

OpenAI reduziu significativamente o preço, tornando-o 5 vezes mais econômico em comparação com text-embedding-ada-002, com o preço por mil tokens reduzido de US$ 0,0001 para US$ 0,00002. Isso torna text-embedding-3-small não apenas uma escolha mais eficiente, mas também mais acessível para desenvolvedores.

incorporação de texto-3-grande

Representando a próxima geração de modelos de incorporação, text-embedding-3-large introduz um aumento substancial nas dimensões, suportando incorporações com até 3.072 dimensões. Este modelo maior fornece uma representação mais detalhada e diferenciada do conteúdo textual. Em termos de desempenho, text-embedding-3-large supera seu antecessor em benchmarks. No MIRACL, a pontuação média subiu de 31,4% para impressionantes 54,9%, destacando a sua capacidade na recuperação multilíngue.

| ada v2 | incorporação de texto-3-pequeno | incorporação de texto-3-grande | ||||

| Tamanho de incorporação | 1536 | 512 | 1536 | 256 | 1024 | 3072 |

| Pontuação média do MTEB | 61,0 | 61,6 | 62,3 | 62,0 | 64,1 | 64,6 |

Da mesma forma, no MTEB, a pontuação média subiu de 61,0% para 64,6%, demonstrando sua superioridade nas tarefas de inglês. Com preço de US$ 0,00013 por mil tokens, text-embedding-3-large atinge um equilíbrio entre excelência de desempenho e economia, oferecendo aos desenvolvedores uma solução robusta para aplicativos que exigem incorporações de alta dimensão.

Encontrar IA do Google Lumièreprimo videomaker de Bard

Suporte nativo para encurtar embeddings

Reconhecendo as diversas necessidades dos desenvolvedores, a OpenAI apresenta suporte nativo para encurtar embeddings. Esta técnica inovadora permite que os desenvolvedores personalizem o tamanho da incorporação ajustando o parâmetro API de dimensões. Ao fazer isso, os desenvolvedores podem trocar algum desempenho por um tamanho de vetor menor sem comprometer as propriedades fundamentais da incorporação. Essa flexibilidade é particularmente valiosa em cenários onde os sistemas suportam apenas incorporações até um determinado tamanho, fornecendo aos desenvolvedores uma ferramenta versátil para vários cenários de uso.

Em resumo, os novos modelos de incorporação da OpenAI representam um avanço significativo em termos de eficiência, acessibilidade e desempenho. Quer os desenvolvedores optem pela representação compacta, mas eficiente, de text-embedding-3-small ou pelos embeddings mais extensos e detalhados de text-embedding-3-large, esses modelos capacitam os desenvolvedores com ferramentas versáteis para extrair insights mais profundos de dados textuais em sua IA formulários.

Para obter informações mais detalhadas sobre os novos modelos de incorporação OpenAI, clique aqui e receba o anúncio oficial.

Crédito da imagem em destaque: Levart_Fotógrafo/Unsplash